学习很潮很流行的Java以及相关框架.

Java基础

Java基础

1. java.lang.*

这是默认导入的包,包含基本类和接口。

- Object:所有类的超类。

- String:不可变字符串类,用于文本处理。

- StringBuilder/StringBuffer:可变字符串类,适用于频繁修改字符串的场景。

StringBuffer是线程安全的版本。 - System:提供系统相关的信息和操作,如

System.out.println()打印输出。 - Math:提供数学计算的方法,如三角函数、对数等。

- Integer, Double 等包装类:基本类型的对象表示形式,支持自动装箱/拆箱。

2. java.util.*

包含了集合框架、日期时间工具、随机数生成器等实用工具类。

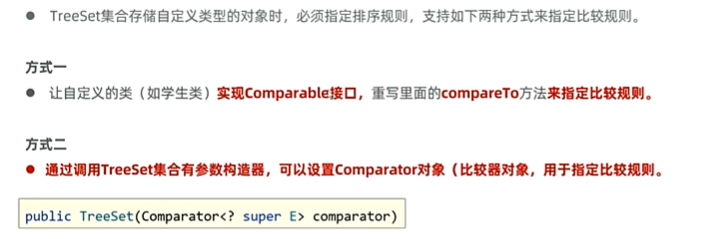

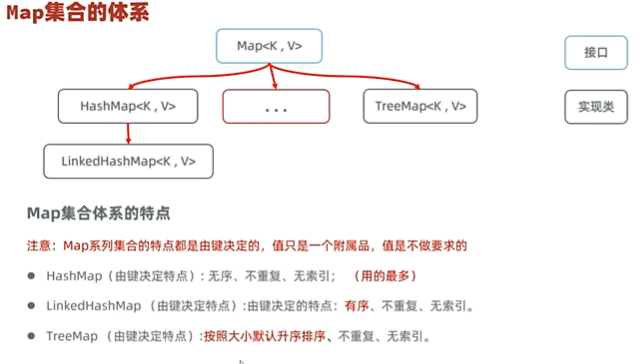

- Collection 接口及其实现类(如ArrayList, LinkedList, HashSet, TreeSet等):提供了不同类型的集合实现。

- Map 接口及其实现类(如HashMap, TreeMap等):键值对存储结构。

- Iterator:遍历集合的标准方式。

- Date, Calendar, LocalDate, LocalDateTime(Java 8+):处理日期和时间。

- Random:生成伪随机数。

- Arrays:提供操作数组的各种静态方法。

函数式编程(function)包提供了一些功能接口

Function<T, R>:接受一个参数并返回结果。Predicate<T>:接受一个输入参数并返回布尔值。方法签名:`boolean test(T t)```BiFunction<T, U, R>:接受两个输入参数并返回结果。方法签名:R apply(T t, U u)UnaryOperator<T>:接受一个参数并返回相同类型的值,是Function<T, T>的特化形式。 方法签名:T apply(T t)BinaryOperator<T>:接受两个相同类型的参数并返回相同类型的值,是BiFunction<T, T, T>的特化形式。 方法签名:`T apply(T t, T u)```BiPredicate<T, U>:接受两个输入参数并返回布尔值。方法签名:boolean test(T t, U u),用于需要基于两个输入值进行条件判断的场景Supplier<T>:适用于你需要从无到有地“生产”数据的场合。它不接收任何参数,但是可以返回你所需要的类型的实例。这使得它非常适合用于延迟初始化、配置加载等场景。BiConsumer<T, U>:当你需要处理或操作一对相关的值,并且这些操作的结果并不重要(即不需要返回值)时非常有用。比如,你可能想要记录一组键值对的日志,或者将两个值合并在一起而不关心最终结果。

3. java.io.*

提供输入输出流的支持,用于读写文件或进行网络通信。

- InputStream/OutputStream:字节流基类。

- Reader/Writer:字符流基类。

- File:文件或目录路径名的抽象表示形式。

- BufferedReader/BufferedWriter, BufferedInputStream/BufferedOutputStream:提高I/O效率的缓冲类。

4. java.nio.*

新的I/O API,提供了更高效的非阻塞I/O操作。

- Path, Paths:用于处理文件系统路径。

- Files:提供对文件的操作方法。

- ByteBuffer及其他缓冲区类型:用于高效地管理字节序列。

5. java.net.*

网络编程相关的API。

- URL, URI:统一资源定位符/标识符。

- URLConnection:与URL建立连接。

- Socket, ServerSocket:TCP/IP套接字编程的基础类。

- DatagramPacket, DatagramSocket:UDP协议的支持。

6. java.text.*

用于格式化和解析文本。

- NumberFormat, DecimalFormat:数字格式化。

- DateFormat, SimpleDateFormat:日期格式化。

- MessageFormat:根据模式格式化消息。

7. java.time.*

Java 8引入的新日期时间API。

- Instant:表示时间线上的一点。

- LocalDate, LocalTime, LocalDateTime:分别表示不带时区的日期、时间和日期时间。

- ZonedDateTime, OffsetDateTime:带有时区信息的日期时间。

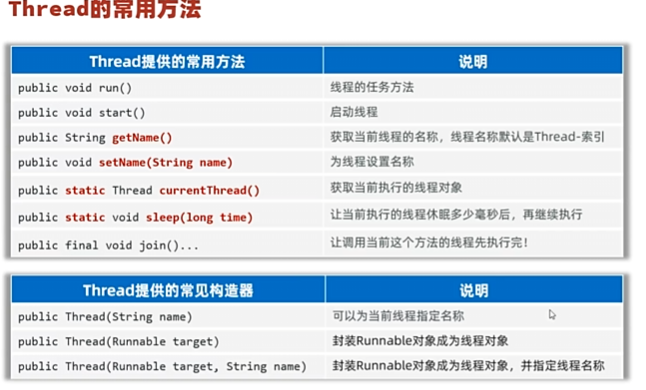

8. 并发相关

- Thread:创建和控制线程。

- Runnable:线程执行的目标接口。

- ExecutorService, Executors:更高级别的线程管理。

- Lock, ReentrantLock:比同步块更灵活的锁定机制。

- ConcurrentHashMap:线程安全的哈希表实现。

9. 其他

- Optional(Java 8+):避免空指针异常的一种设计模式。

- Stream API(Java 8+):提供了一种高效且易于使用的集合元素处理方式。

| 访问修饰符 | 同一类 | 同一包 | 子类(不同包) | 全局 |

|---|---|---|---|---|

public | 是 | 是 | 是 | 是 |

protected | 是 | 是 | 是 | 否 |

| 默认 | 是 | 是 | 否 | 否 |

private | 是 | 否 | 否 | 否 |

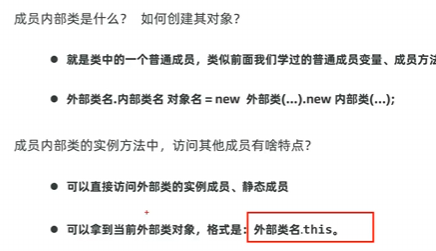

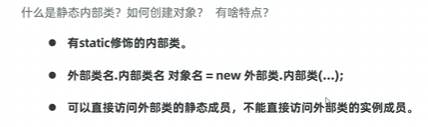

内部类

成员内部类,静态内部类,局部内部类,匿名内部类

1

2

3

4

5

6

7

8

9

10

11

12// 成员内部类

class outerclass {

private String name;

private static String age;

public class innerclass {

void display() {

System.out.println("This is an inner class");

System.out.println(name);

System.out.println(age);

}

}

}

1

2

3

4

5

6

7public static class innercls {

void display() {

System.out.println("This is an inner class");

System.out.println(innercls.this);

System.out.println(age);

}

}

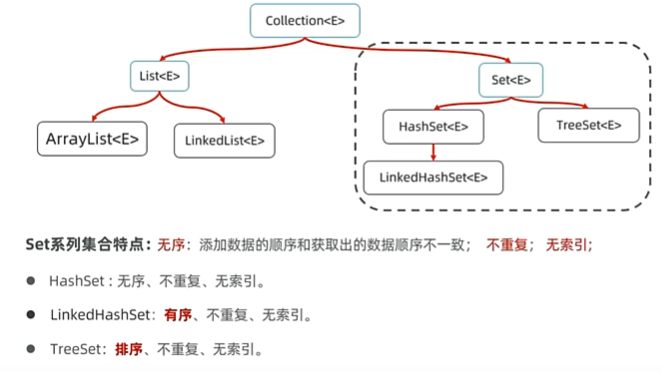

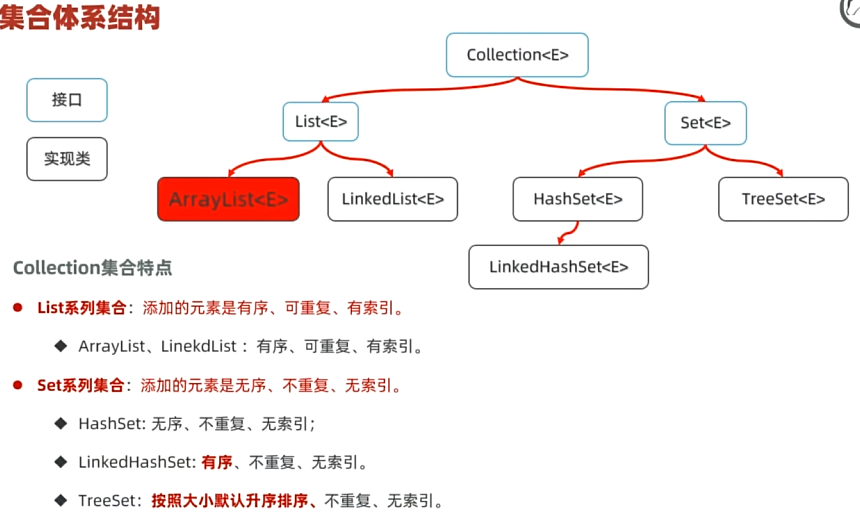

集合Collection与Map

数组和集合的区别:

数组

固定大小:数组一旦创建,其大小是固定的,不能动态增加或减少元素。

类型安全:数组可以是基本数据类型(如

int[],double[])或对象类型(如String[])。对于对象类型的数组,所有元素都必须是该类的实例或者null。内存连续:数组中的元素在内存中是连续存储的,这使得访问速度非常快,因为可以通过计算偏移量直接访问任何元素(时间复杂度为 O(1))。

声明方式

1

2int[] numbers = new int[5]; // 创建一个包含5个整数的数组

String[] names = {"Alice", "Bob"}; // 初始化时赋值

优点

- 访问速度快,支持随机访问。

- 对于小规模、固定数量的数据集非常适合。

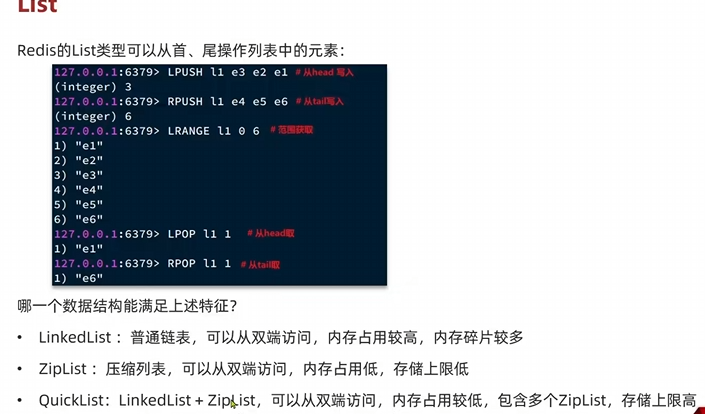

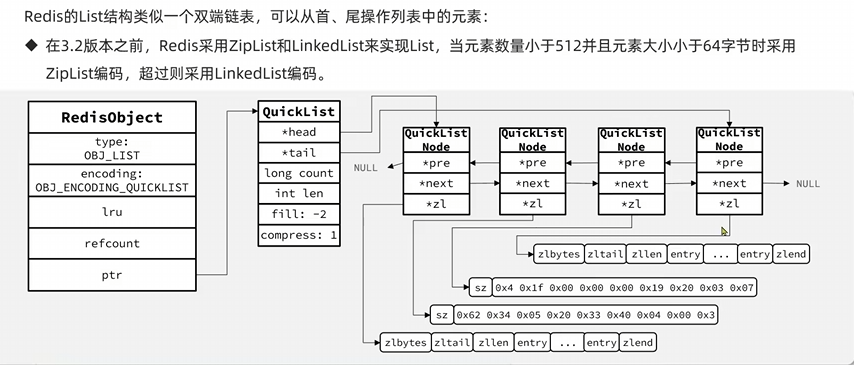

List

定义与特性

动态大小:

List接口的主要实现类(如ArrayList,LinkedList)允许动态添加和删除元素,这意味着你可以根据需要扩展或缩小列表的大小。接口与实现:

List是一个接口,常用的实现包括ArrayList和LinkedList。ArrayList底层基于数组实现,而LinkedList则是一个双向链表。类型安全:

List只能存储对象,不能直接存储基本数据类型(但可以使用自动装箱/拆箱功能处理基本数据类型)。声明方式

1

2

3List<String> names = new ArrayList<>();

names.add("Alice");

names.add("Bob");

优点

- 动态大小,方便添加和删除元素。

- 提供了丰富的操作方法,比如

add(),remove(),get(),indexOf()等等。 - 更好的抽象层次,代码更加灵活易读。

缺点

- 相比于数组,某些操作可能效率较低,例如在

ArrayList中插入或删除中间位置的元素会导致其他元素移动;而在LinkedList中查找元素则需要从头或尾遍历整个列表。

ArrayList使用数组实现,查询快,增删慢

LinkedList使用双向链表实现,查询慢,增删快,尤其对于首尾操作

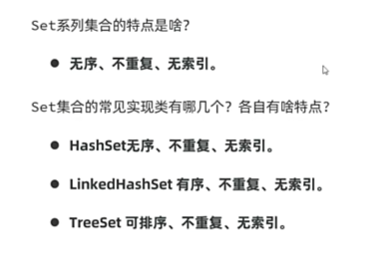

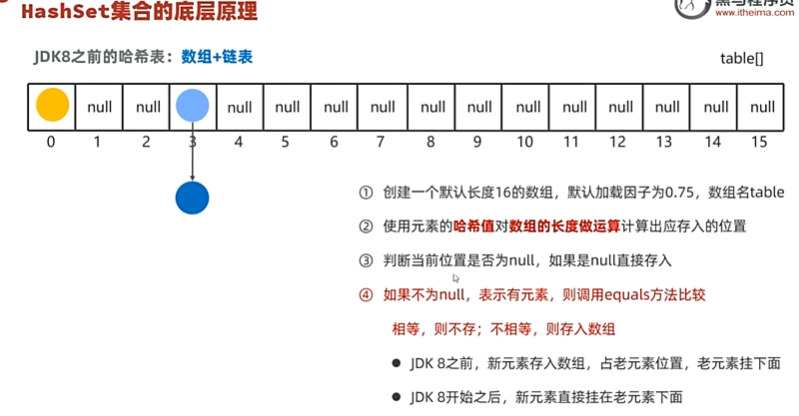

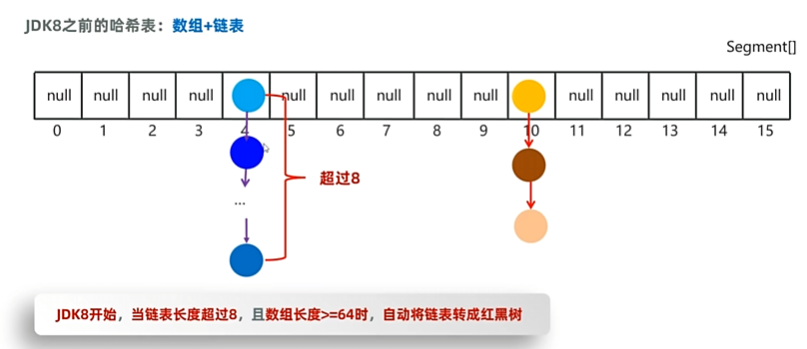

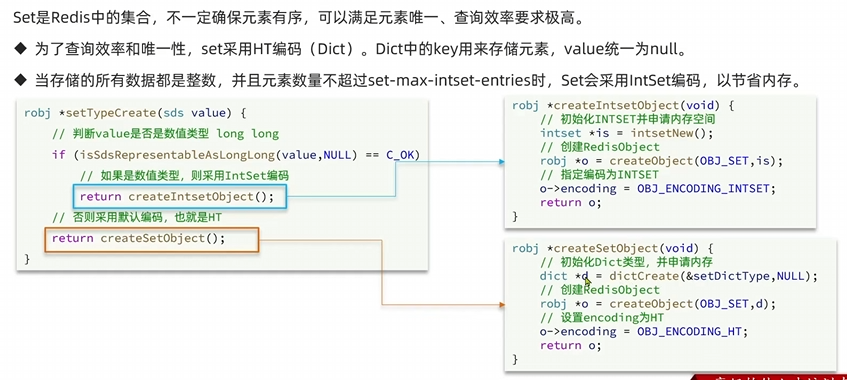

Set

HashSet使用哈希表实现,增删改查性能较好

HashSet去重主要依赖于两个关键方法:hashCode() 和 equals()。

- hashCode() 方法:

- 当你尝试将一个对象添加到 HashSet 中时,HashSet 会首先调用这个对象的

hashCode()方法来计算该对象的哈希值。 - 这个哈希值决定了对象在内部哈希表中的存储位置(即所谓的“桶”)。

- 当你尝试将一个对象添加到 HashSet 中时,HashSet 会首先调用这个对象的

- equals() 方法:

- 如果两个对象有相同的哈希值(或者它们被分配到了同一个桶中),HashSet 将使用

equals()方法来进一步检查这两个对象是否真正相等。 - 如果

equals()返回true,则认为这两个对象是重复的,新对象不会被添加到集合中。如果equals()返回false,即使哈希值相同,这两个对象也被认为是不同的,并且都会被添加到集合中。

- 如果两个对象有相同的哈希值(或者它们被分配到了同一个桶中),HashSet 将使用

对于自定义类的对象,如果你希望它们能够正确地在 HashSet 中进行去重,你需要重写 hashCode() 和 equals() 方法,以确保具有相同业务含义的对象返回相同的哈希码并且 equals() 方法也返回 true。

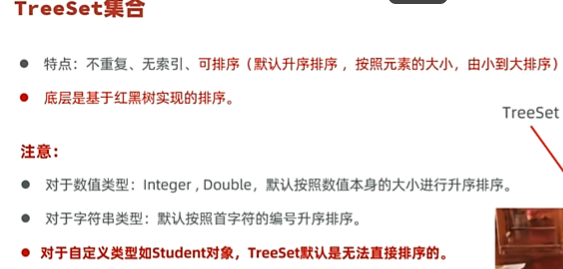

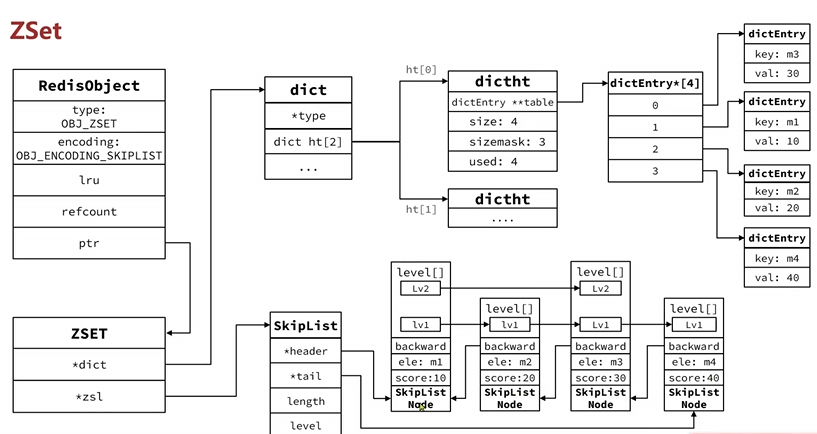

TreeSet底层基于红黑树,可排序,不重复,无索引

Map

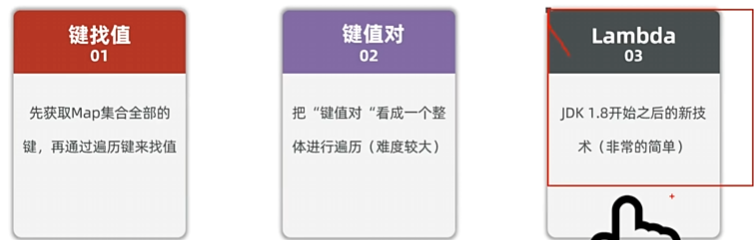

Map的遍历方式

使用 for-each 循环和 entrySet()

这是最常用的遍历方式之一,因为它提供了对键和值的访问。1

2

3for (Map.Entry<String, Integer> entry : map.entrySet()) {

System.out.println(entry.getKey() + ": " + entry.getValue());

}

使用迭代器

使用迭代器可以更灵活地控制遍历过程。1

2

3

4

5Iterator<Map.Entry<String, Integer>> iterator = map.entrySet().iterator();

while (iterator.hasNext()) {

Map.Entry<String, Integer> entry = iterator.next();

System.out.println(entry.getKey() + ": " + entry.getValue());

}

使用 Java 8 的 Stream API

通过 stream() 方法可以利用 Stream API 来遍历或进行其他操作。1

2

3map.entrySet().stream().forEach(entry ->

System.out.println(entry.getKey() + ": " + entry.getValue())

);

或者对于某些特定的操作,比如过滤、映射等:1

2

3map.entrySet().stream()

.filter(entry -> entry.getValue() > 1)

.forEach(entry -> System.out.println(entry.getKey()));

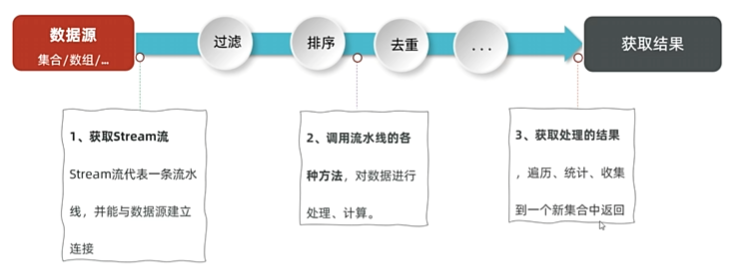

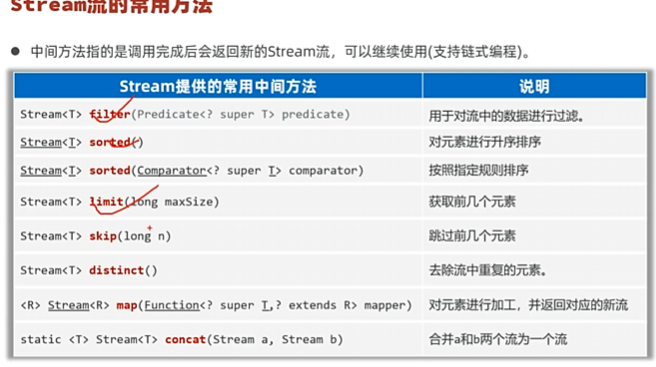

Stream流包括中间方法和最终方法,中间方法使用filter,map,调用完成后会返回新的流

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20List<String> alist = new ArrayList<>();

alist.add("a");

alist.add("b");

List<String> list = alist.stream().map((String a) -> a + "a").toList();

List<Double> blist = new ArrayList<>();

list.stream().filter(s-> !s.isEmpty()).forEach(System.out::println);

list.stream().sorted(Comparator.comparingDouble(String::length).reversed()).forEach(System.out::println);

blist.stream().sorted(Double::compare).forEach(System.out::println);

// 去重 limit只需要一个参数 skip跳过前几个

blist.stream().distinct().skip(1).limit(2).forEach(System.out::println);

// 转换成map

list.stream().collect(Collectors.toMap(Function.identity(), String::length)).forEach((k, v) -> System.out.println(k + ":" + v));

Stream<String> a = Stream.of("a", "b", "c");

Stream<Integer> integerStream = Stream.of(1, 2);

// 合并两个流

Stream.concat(a, integerStream).forEach(System.out::println);

异常、泛型与集合框架

Java中异常的类继承体系

运行时异常(extends RuntimeException:数组索引越界

编译异常(extends Exception). 编译时异常需要通过try-catch或throw丢出异常进行处理,

运行时异常不需要特别处理

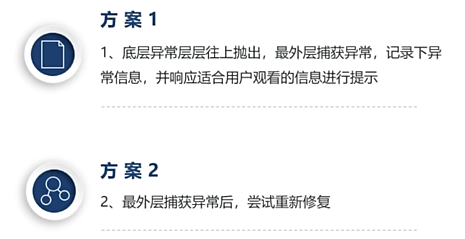

此外异常可以分为业务类和运行逻辑类,一些代码中的异常应该被catch然后向上抛给业务类或者直接处理.

泛型允许编写可以处理不同类型数据的类、接口和方法,而无需在代码中明确指定具体类型。泛型提供了更强的类型检查,并且消除了对类型转换的需求,从而使得代码更加安全和易于维护。

类型参数:在定义泛型类或方法时使用占位符(通常为大写字母如 T, E, K, V 等),代表实际应用中的类型。

- 类型安全:编译器会在编译期进行类型检查,减少运行时出现的

ClassCastException错误。 - 消除类型转换:由于类型信息在编译时已知,因此不需要显式的类型转换。

使用泛型类

1 | Box<Integer> integerBox = new Box<>(); |

泛型方法

你也可以定义泛型方法,即在方法级别上使用泛型。例如:1

2

3

4

5

6

7

8

9

10

11

12

13public static <T> void printArray(T[] array) {

for (T element : array) {

System.out.println(element);

}

}

public static void main(String[] args) {

Integer[] intArray = {1, 2, 3};

String[] stringArray = {"A", "B", "C"};

printArray(intArray);

printArray(stringArray);

}

在这个例子中,<T> 在方法签名前声明了类型参数,这样这个方法就可以接受任意类型的数组作为参数。

泛型接口

类似地,也可以定义泛型接口:1

2

3

4public interface Container<T> {

void add(T item);

T get(int index);

}

然后实现这个接口:1

2

3

4

5

6

7

8

9

10

11

12

13public class StringContainer implements Container<String> {

private List<String> items = new ArrayList<>();

public void add(String item) {

items.add(item);

}

public String get(int index) {

return items.get(index);

}

}

Java 泛型是在 Java 5 中引入的,而在此之前已经存在了大量的 Java 代码库。如果直接在 JVM 层面实现泛型支持,那么这些现有的代码可能会因为缺乏泛型信息而不兼容。通过类型擦除,Java 编译器能够在编译时移除泛型类型信息,并将泛型代码转换为非泛型代码,这样就可以确保新旧代码可以无缝地一起工作

通配符

有时可能需要编写能够与多种类型工作的代码,但并不需要知道这些类型的具体细节。这时可以使用通配符 ?:

- 无界通配符:

<?>表示可以是任何类型。 - 有界通配符:

<? extends T>和<? super T>分别表示类型必须是T或其子类,以及T或其父类。

泛型的优点

- 类型安全:编译器可以在编译时进行更多的类型检查,减少运行时错误。

- 消除强制类型转换:不再需要手动将对象转换回原始类型。

- 提高代码重用性:通过泛型,相同的逻辑可以应用于不同的数据类型。

Java集合是一种容器,类似于数组但集合的大小可变.

多线程与线程池

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58package com.sekyoro.tutorThread;

import java.util.concurrent.Callable;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.FutureTask;

/**

* @projectName: workspace

* @package: com.sekyoro.tutorThread

* @className: threadDemo

* @author: proanimer

* @description:

* @date: 2025/3/19 16:19

*/

class easyThread extends Thread {

public void run() {

System.out.println("This is a thread");

}

}

class miniThread implements Runnable{

public void run() {

System.out.println("This is a mini thread");

}

}

class miniCallable implements Callable<Integer> {

private int n;

public miniCallable() {

this.n = 0;

}

public miniCallable(int n) {

this.n = n;

}

public Integer call() throws Exception {

System.out.println("Calculating...");

return 10;

}

public int getN() {

return n;

}

}

public class threadDemo {

public static void main(String[] args) throws ExecutionException, InterruptedException {

Thread et = new easyThread();

et.start();

new Thread(new miniThread()).start();

Callable<Integer> mc = new miniCallable();

FutureTask<Integer> ft = new FutureTask<>(mc);

new Thread(ft).start();

Integer i = ft.get();

}

}

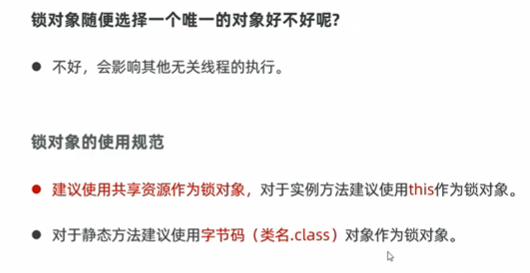

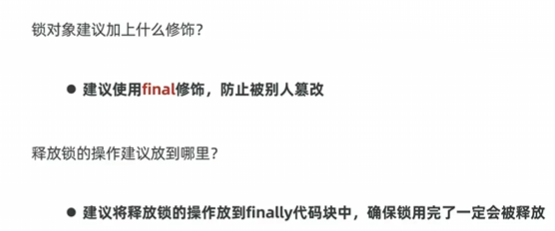

线程同步解决线程安全问题

同步代码块1

2

3synchronized() {

}

同步方法

1

2

3synchronized void draw(int m) {

money -= m;

}

Lock锁

1

2

3

4ReentrantLock lock = new ReentrantLock();

lock.lock();

...

lock.unlock();

显式锁(Explicit Lock)

ReentrantLock 类提供了比synchronized更灵活的锁操作,例如可中断的锁等待、尝试非阻塞获取锁、超时获取锁等。

1

2

3

4

5

6

7Lock lock = new ReentrantLock();

lock.lock(); // 获取锁

try {

// 受保护的代码

} finally {

lock.unlock(); // 确保释放锁

}

- 读写锁(ReadWriteLock)

ReadWriteLock 接口 和 ReentrantReadWriteLock 实现类.允许多个读操作同时进行,但在写操作时排斥所有其他读写操作。适用于读多写少的场景。1

2

3

4

5

6

7

8

9

10

11

12

13

14ReadWriteLock rwl = new ReentrantReadWriteLock();

rwl.readLock().lock(); // 获取读锁

try {

// 读取操作

} finally {

rwl.readLock().unlock(); // 释放读锁

}

rwl.writeLock().lock(); // 获取写锁

try {

// 写入操作

} finally {

rwl.writeLock().unlock(); // 释放写锁

}

- 条件变量(Condition)

Condition 接口与显式锁配合使用,提供类似1

2

3

4

5

6

7

8

9

10

11Lock lock = new ReentrantLock();

Condition condition = lock.newCondition();

lock.lock();

try {

condition.await(); // 相当于 wait()

// ...

condition.signal(); // 相当于 notify()

} finally {

lock.unlock();

}

- StampedLock

StampedLock 类是Java 8引入的一种新的锁类型,支持乐观读锁策略,适用于读多写少且大部分读操作不会发生冲突的情况。它提供了三种模式:写锁、悲观读锁和乐观读锁。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21StampedLock stampedLock = new StampedLock();

long stamp = stampedLock.readLock(); // 悲观读锁

try {

// 读取操作

} finally {

stampedLock.unlockRead(stamp);

}

stamp = stampedLock.writeLock(); // 写锁

try {

// 写入操作

} finally {

stampedLock.unlockWrite(stamp);

}

long optimisticStamp = stampedLock.tryOptimisticRead(); // 乐观读锁

// 验证并使用乐观读锁...

if (!stampedLock.validate(optimisticStamp)) {

// 如果验证失败,则需要重新获取悲观读锁或写锁

}

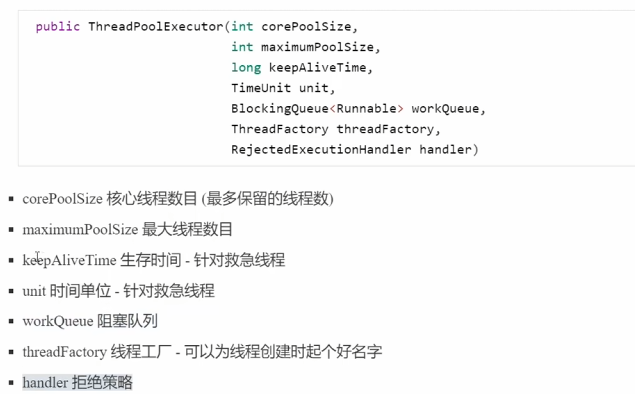

线程池

- ThreadPoolExecutor创建线程池

1 | // 1. 创建线程池 |

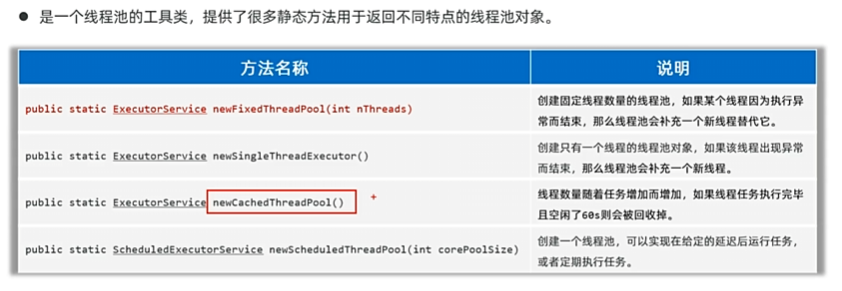

- 利用Executors创建线程池

利用ThreadPoolExecutor设置不同参数调用1

2

3

4

5

6public static ExecutorService newFixedThreadPool(int nThreads) {

return new ThreadPoolExecutor(nThreads, nThreads,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>());

}

反射、注解与动态代理

反射是指在运行时动态地获取类的信息以及操作对象的能力。通常情况下,Java 编译器会在编译期确定所有类型和成员变量的访问权限及调用方式,而反射则允许你在运行时进行这些操作1

2

3

4

5

6

7

8

9

10

11

12

13// 方式一: 直接通过类名获取

Class<?> clazz = MyClass.class;

// 方式二: 使用对象的 getClass() 方法

MyClass obj = new MyClass();

clazz = obj.getClass();

// 方式三: 通过全限定类名字符串

try {

clazz = Class.forName("com.example.MyClass");

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

得到的class类可以用来创建实例、访问字段、调用方法等

创建实例1

2

3

4

5

6

7

8

9

10

11

12

13

14

15try {

// 假设 MyClass 有一个无参构造函数

Object obj = clazz.getDeclaredConstructor().newInstance();

} catch (Exception e) {

e.printStackTrace();

}

try {

// 获取指定参数类型的构造函数

Constructor<MyClass> constructor = clazz.getConstructor(paramType.class);

// 创建实例

MyClass instance = constructor.newInstance(args);

} catch (Exception e) {

e.printStackTrace();

}

注解(Annotations)是一种元数据形式,它提供了关于程序代码的额外信息,但这些信息并不直接改变程序的运行逻辑。注解自 Java 5 引入以来,已经成为 Java 开发中不可或缺的一部分,用于简化开发流程、提供配置信息、增强代码的功能等

- 定义:注解是接口的一种特殊形式,它通过

@interface关键字来定义,并可以附加到类、方法、变量、参数、包声明等语言元素上。 - 用途:主要用于编译时检查、运行时处理和生成源代码或文档。

- 标记注解:没有成员变量,仅作为标记使用,如

@Override。 - 单值注解:只有一个值,通常省略名称直接指定值,如

@SuppressWarnings("unchecked")。 - 完整注解:包含多个成员变量,需要明确指定每个成员的值。

元注解是指用来注解其他注解的注解,主要包括以下几个:

@Retention:定义了注解的存在阶段(SOURCE, CLASS, RUNTIME)。@Target:指定了注解可以应用的目标元素类型(TYPE, FIELD, METHOD, PARAMETER, CONSTRUCTOR, LOCAL_VARIABLE 等)。@Documented:表明这个注解应该被 javadoc 工具记录。@Inherited:允许子类继承父类中的注解。@Repeatable:从 Java 8 开始支持,表示相同的注解可以在同一地方多次使用。

注解的解析

检查方法和类等是否包含对应注解,若包含则进行相关调用1

2

3

4

5

6

7

8

9

10

11

12

13annotationDemo annotationDemo = new annotationDemo();

Class<?> aClass = annotationDemo.class;

Method[] methods = aClass.getMethods();

for (Method method : methods) {

if (method.isAnnotationPresent( MyTest.class)) {

try {

MyTest declaredAnnotation = method.getDeclaredAnnotation(MyTest.class);

method.invoke(annotationDemo);

} catch (IllegalAccessException | InvocationTargetException e) {

throw new RuntimeException(e);

}

}

}

动态代理

Proxy.newProxyInstance创建代理,参数包括类加载器,需要实现的接口,和代理需要做的事情1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23public class ProxyUtils {

public static StarService createProxy(StarService starService){

StarService o = (StarService)Proxy.newProxyInstance(ProxyUtils.class.getClassLoader(), starService.getClass().getInterfaces(), new InvocationHandler() {

public Object invoke(Object proxy, Method method, Object[] args) throws Throwable {

String methodName = method.getName();

if("sing".equals(methodName)) {

System.out.println("sing a song: " + args[0]);

}else{

System.out.println("dance a dance");

}

if(method.getReturnType().equals(Void.TYPE)) {

return null;

}else{

return method.invoke(starService,args);

}

}

});

return o;

}

}

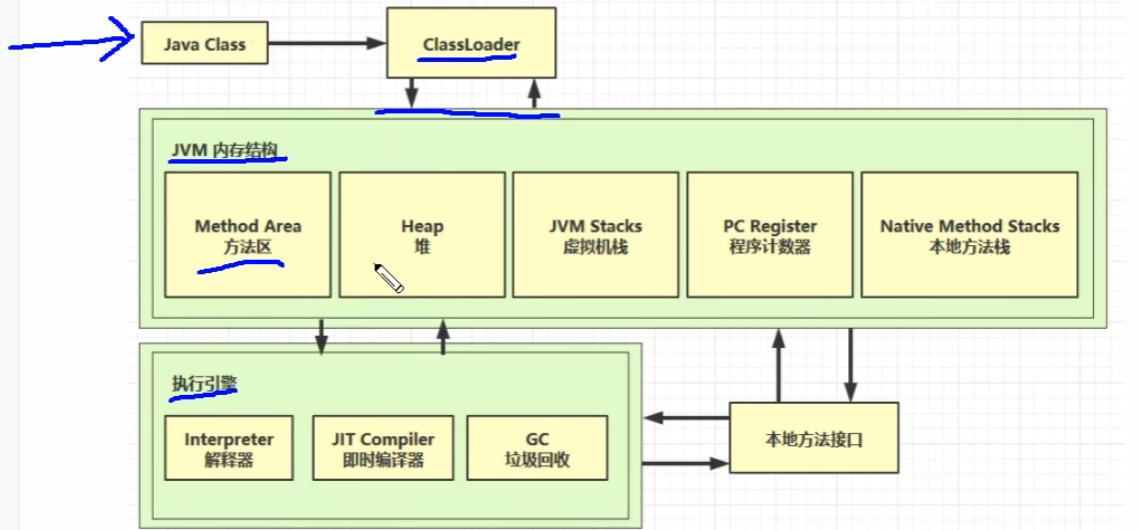

ClassLoader

类加载过程主要包括三个阶段:加载、链接和初始化。

- 加载:通过类的全限定名获取定义此类的二进制字节流,并将其转换为方法区中的运行时数据结构,在内存中生成一个代表该类的

java.lang.Class对象。 - 链接:包括验证、准备和解析三个步骤。验证确保被加载类的正确性;准备则为类变量分配内存并设置默认初始值;解析是将类、接口、字段和方法的符号引用转为直接引用的过程。

- 初始化:执行类构造器

<clinit>()方法的过程,对静态变量和静态代码块进行初始化。

Java 类加载器使用双亲委派模型来搜索类或资源。当一个类加载器收到类加载请求时,它首先不会自己去尝试加载这个类,而是把这个请求委派给父类加载器完成,每一层的类加载器都是如此,因此所有的类加载请求最终都会传送到顶层的启动类加载器。只有当父类加载器无法加载该类时,子类加载器才会尝试自己加载

Java 提供了三种内置的类加载器:

- Bootstrap ClassLoader:这是最顶层的类加载器,由本地代码实现,通常用于加载核心 JDK 类库(如

rt.jar)。 无法直接访问,显示为null - Extension ClassLoader:扩展类加载器,用来加载位于

$JAVA_HOME/jre/lib/ext目录下的 JAR 包。 (目前使用PlatformClassLoader,加载 JDK 提供的平台模块中的类,例如java.sql,java.xml,javax.*等模块化的平台类。) - Application ClassLoader:应用程序类加载器,负责加载用户类路径(ClassPath)上指定的类库

Java 提供了一些常用的方法来操作类加载器:

(1) loadClass(String name)

加载指定名称的类或接口。如果已经加载过,则直接返回对应的 Class 对象;如果没有,则按照双亲委派机制尝试加载。1

2

3

4

5try {

Class<?> clazz = ClassLoader.getSystemClassLoader().loadClass("com.example.MyClass");

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

(2) findClass(String name)

查找指定名称的类。默认实现会抛出 ClassNotFoundException 异常,通常需要自定义类加载器覆盖此方法以提供具体的类查找逻辑。

(3) defineClass(byte[] b, int off, int len)

将一个字节数组转换成一个类的 Class 对象。一般不直接调用,主要用于自定义类加载器。

(4) getResource(String name) 和 getResourceAsStream(String name)

用于查找资源文件。前者返回资源的 URL,后者返回资源的输入流。1

2URL resourceUrl = getClass().getClassLoader().getResource("config.properties");

InputStream inputStream = getClass().getClassLoader().getResourceAsStream("config.properties");

(5) getParent()

返回该类加载器的父类加载器。注意,Bootstrap ClassLoader 没有父类加载器,所以对于 Bootstrap ClassLoader 调用 getParent() 将返回 null。

4. 自定义类加载器

有时我们需要根据特定的需求来自定义类加载器。可以通过继承 java.lang.ClassLoader 并重写 findClass 方法来实现。1

2

3

4

5

6

7

8

9

10

11

12

13public class MyClassLoader extends ClassLoader {

protected Class<?> findClass(String name) throws ClassNotFoundException {

byte[] classData = loadClassData(name); // 实现类数据加载逻辑

return defineClass(name, classData, 0, classData.length);

}

private byte[] loadClassData(String className) {

// 加载类数据的逻辑

return new byte[0];

}

}

以下是实现自定义类加载器的基本步骤:

继承

ClassLoader- 创建一个类并继承

ClassLoader。

- 创建一个类并继承

重写

findClass()方法(遵从双亲委派机制)- 实现自定义的类加载逻辑。

调用

defineClass()方法- 将字节码转换为

Class对象。

class对象相同需要classloader相同,相同的classloader进行loadclass相同的类得到的class相同

- 将字节码转换为

1 | import java.io.ByteArrayOutputStream; |

线程上下文加载器

线程上下文类加载器(Thread Context ClassLoader)是 Java 提供的一种机制,允许开发者在线程中设置和获取类加载器。这种机制主要用于解决某些特定场景下类加载的问题,尤其是在复杂的类层次结构或模块化系统中。

线程上下文类加载器的作用

- 解决类加载器隔离问题:

- 在 Java 应用程序中,不同的类加载器可能会形成类加载器树,这导致了类加载器之间的隔离性。

- 例如,在 Web 容器或 OSGi 等环境中,不同应用或模块可能使用不同的类加载器来加载各自的类。在这种情况下,如果一个类需要加载另一个类加载器负责加载的类,则会遇到问题。

- 线程上下文类加载器提供了一种绕过双亲委派模型的方式,允许当前线程使用指定的类加载器来加载类。

- 支持框架和库的开发:

- 许多框架和库(如 JNDI、JDBC 驱动等)依赖于线程上下文类加载器来加载必要的类。

- 这些框架通常不知道具体的类加载器,因此它们可以利用线程上下文类加载器来动态地加载所需的类。

1 | public class ThreadContextClassLoaderExample { |

JVM

程序计数器: 线程私有

垃圾回收

判断对象可以回收

引用计数法

工作原理

- 初始化:每当创建一个新的对象时,该对象的引用计数器被初始化为1。

- 增加引用:每当有新的引用指向这个对象时(例如,将对象赋值给另一个变量),该对象的引用计数加1。

- 减少引用:每当某个引用不再指向该对象时(例如,变量超出作用域或重新赋值),该对象的引用计数减1。

- 回收内存:当一个对象的引用计数降为0时,表示没有其他引用指向该对象,这时就可以立即回收该对象所占用的内存。

缺点:

无法处理循环引用:如果两个或多个对象相互引用形成环状结构,则即使这些对象实际上已经不可达,它们的引用计数也不会变为0,导致内存泄漏。为了克服这个问题,一些语言引入了弱引用(weak references)或专门的循环检测机制。

多线程环境下的复杂性:在多线程环境下,对引用计数的修改需要同步操作,以防止竞态条件(race condition),这也增加了实现的复杂性和运行时的开销

可达性分析算法

可达性分析的基本思想是从一组被称为“根节点”(root set)的对象开始,遍历所有可以通过这些根节点直接或间接引用到的对象,并将它们标记为存活。未被标记的对象则被认为是不可达的,可以被安全地回收。

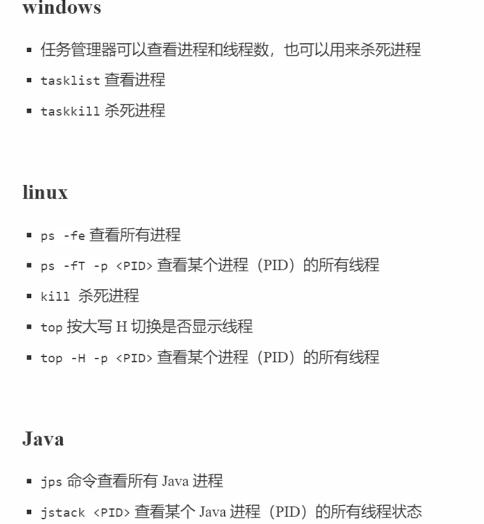

在命令行中输入

jps可以列出所有由当前用户启动的 Java 进程的基本信息

-q:仅输出 JVM 的进程 ID,不输出类名、jar 名等信息

-l:输出主类的完整包名;如果进程执行的是 jar 文件,则输出 jar 文件的完整路径

1 | jmap -dump:[live,]format=b,file=<filename>.hprof <pid> |

live:如果指定了这个选项,则只转储存活的对象;如果不指定,则转储所有对象。format=b:表示输出格式为二进制,默认就是二进制格式,所以通常省略不写。<filename>.hprof:指定生成的堆转储文件的名字。<pid>:目标Java进程的进程ID。

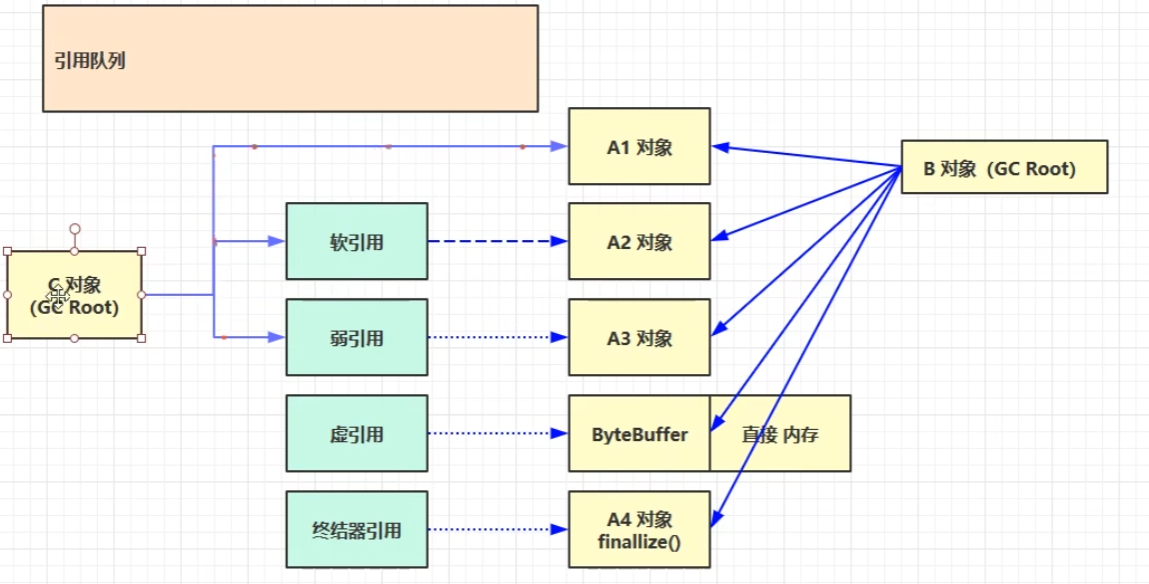

引用

强引用 软引用 弱引用

软引用:垃圾回收时且内存不足时会被回收掉

虚引用 引用队列

终结器引用

- 强引用:日常编程中最常用的引用类型,几乎所有对象都是通过强引用创建的。

- 软引用:适用于缓存场景,当内存不足时,允许GC回收缓存数据。

- 弱引用:适合于需要自动清理的资源管理场景,例如监听器或回调函数列表中的对象。

- 虚引用:主要用于了解对象何时被垃圾回收,常用于做一些清理工作,比如清除本地内存、关闭文件等

回收算法

标记-清除

- 这是最基本的垃圾回收算法,分为两个阶段:标记和清除。在标记阶段,GC从根集合(GC Roots)开始遍历所有可达对象,并标记它们为存活对象;在清除阶段,未被标记的对象即被视为垃圾对象并被回收

- 优点是实现简单,适用于任何对象的内存管理;缺点是会产生内存碎片,因为删除了不可达对象后留下的空闲内存可能是不连续的,这可能导致后续大对象分配失败。

复制(Copying)算法:

- 复制算法将堆内存划分为两部分,每次只使用其中一部分。当这部分内存用完时,GC会暂停应用,将存活对象复制到另一部分内存中,并清空原内存区域

- 此算法避免了内存碎片问题,但代价是只能使用一半的内存空间,且对于存活率较高的对象效率较低。

复制算法将可用内存分为两部分,通常称为From Space和To Space。

程序只使用其中一部分(From Space),当这部分内存满后,GC会遍历From Space中的所有对象,将存活的对象复制到To Space,并且更新这些对象的引用指向新的位置。

清理完From Space后,它变为可用空间,而To Space则成为下次分配新对象的空间

这个过程有效地避免了内存碎片化的问题,因为每次清理后的内存区域都是连续的

标记-整理(Mark-Compact)算法:

- 标记-整理算法结合了标记-清除和复制的优点,在标记阶段与标记-清除类似,但在清除阶段,它会将存活的对象移动到内存的一端,然后清理掉端边界以外的空间

- 它解决了内存碎片问题,但需要移动存活对象,增加了回收的开销。

标记整理算法首先执行标记阶段,这与标记清除算法相同,即通过可达性分析找到所有存活的对象并进行标记。

接下来是整理阶段,在这个阶段,所有的存活对象会被移动到内存的一端,这样可以确保所有的空闲空间都在另一端,形成一个连续的块。

最后一步是对剩余的未被标记的部分进行清理,释放出连续的内存块

分代收集(Generational Collection)算法:

- 分代收集是一种基于对象生命周期特征优化的策略,将堆内存划分为年轻代(Young Generation)和老年代(Old Generation)。年轻代通常采用复制算法,而老年代则采用标记-清除或标记-整理算法

- 这种方法利用了大多数对象“朝生夕死”的特点,提高了垃圾回收的效率。

1. 堆内存分区

在分代垃圾回收中,堆内存通常被划分为三个主要区域:

- 年轻代(Young Generation):

- 主要用于存放新创建的对象。

- 进一步细分为一个 Eden 区和两个 Survivor 区(From 和 To)。

- 老年代(Old Generation):

- 存放的是经过多次垃圾回收后仍然存活的对象,这些对象被认为具有较长的生命期。

- 永久代/元空间(Permanent Generation/Metaspace):

- 在 Java 8 之前称为永久代,之后改为元空间,主要用于存储类的元数据、方法描述等信息,并不属于堆的一部分。

2. 分代垃圾回收过程

年轻代垃圾回收(Minor GC)

- Eden 区与 Survivor 区:当一个新的对象被创建时,它首先被分配到 Eden 区。如果 Eden 区满了,就会触发一次 Minor GC。

- 复制算法:Minor GC 使用这种算法来清理垃圾对象。在这个过程中,存活的对象会被复制到其中一个 Survivor 区(假设为 From),同时清除 Eden 区。

- Survivor 区交换:下一次 Minor GC 发生时,Eden 区和当前的 From Survivor 区中的存活对象会被复制到另一个 Survivor 区(To)。然后这两个角色会互换(即原来的 From 变成 To,反之亦然)。

- 晋升至老年代:当某个对象经历了若干次 Minor GC 后仍然存活(默认情况下是 15 次),它将被移动到老年代。

老年代垃圾回收(Major GC / Full GC)

- Full GC:当老年代也满时,将会触发 Full GC,这会同时清理年轻代和老年代。由于老年代中的对象通常是长期存活的,所以 Full GC 的频率远低于 Minor GC,但其执行成本更高。

- 标记-清除或标记-整理算法:对于老年代,可能会使用这两种算法之一。标记-清除算法简单地标识并删除不再使用的对象,但会导致内存碎片化;标记-整理算法则会在清理的同时压缩内存,减少碎片。

一些常用的 JVM 参数,用于调整分代垃圾回收行为:

- 年轻代相关参数:

-Xmn<size>:设置年轻代大小。-XX:SurvivorRatio=<ratio>:设置 Eden 区与 Survivor 区的比例(默认为 8:1)。-XX:MaxTenuringThreshold=<n>:设置对象晋升到老年代的最大年龄(默认为 15)。

- 老年代相关参数:

-Xms<size>:设置堆内存初始大小。-Xmx<size>:设置堆内存最大大小。

- 垃圾回收器选择:

-XX:+UseSerialGC:启用 Serial 收集器。-XX:+UseParallelGC:启用 Parallel 收集器。-XX:+UseConcMarkSweepGC:启用 CMS 收集器。-XX:+UseG1GC:启用 G1 收集器。-XX:+UseZGC:启用 ZGC 收集器。-XX:+UseShenandoahGC:启用 Shenandoah 收集器

(1) 基本 GC 日志

-XX:+PrintGCDetails:打印详细的垃圾回收日志。-XX:+PrintGC或-verbose:gc:打印简单的垃圾回收日志(仅显示每次 GC 的时间和类型)。

示例:1

java -XX:+PrintGCDetails -XX:+PrintGC MyApplication

输出示例:1

[GC (Allocation Failure) [PSYoungGen: 1024K->512K(2048K)] 1024K->768K(6144K), 0.0023456 secs] [Times: user=0.01 sys=0.00, real=0.00 secs]

(2) 打印时间戳

-XX:+PrintGCTimeStamps:在每条 GC 日志前添加时间戳(从 JVM 启动开始的时间)。-XX:+PrintGCDateStamps:在每条 GC 日志前添加实际日期和时间。

示例:1

java -XX:+PrintGCDetails -XX:+PrintGCTimeStamps -XX:+PrintGCDateStamps MyApplication

输出示例:1

2023-03-29T12:00:00.000+0000: 1.234:

(3) 将 GC 日志写入文件

-Xloggc:<file>:将 GC 日志写入指定文件。- 结合其他参数可以生成更详细的日志文件。

示例:1

java -XX:+PrintGCDetails -Xloggc:gc.log MyApplication

2. 调整堆内存大小

-Xms<size>:设置 JVM 堆内存的初始大小。例如-Xms512m表示初始堆大小为 512MB。-Xmx<size>:设置 JVM 堆内存的最大大小。例如-Xmx2g表示最大堆大小为 2GB。

1 | java -Xms512m -Xmx2g MyApplication |

3. 调整年轻代和老年代比例

-XX:NewRatio=<ratio>:设置老年代与年轻代的比例。例如-XX:NewRatio=3表示老年代与年轻代的比例为 3:1。-XX:SurvivorRatio=<ratio>:设置 Eden 区与 Survivor 区的比例。例如-XX:SurvivorRatio=8表示 Eden 区与每个 Survivor 区的比例为 8:1。

1 | java -XX:NewRatio=3 -XX:SurvivorRatio=8 MyApplication |

4. 设置元空间大小

-XX:MetaspaceSize=<size>:设置元空间的初始大小。-XX:MaxMetaspaceSize=<size>:设置元空间的最大大小。

示例:1

java -XX:MetaspaceSize=128m -XX:MaxMetaspaceSize=256m MyApplication

5. 设置线程栈大小

-Xss<size>:设置每个线程的栈大小。例如-Xss512k表示每个线程的栈大小为 512KB。

1 | java -Xss512k MyApplication |

6. 启用特定垃圾回收器

-XX:+UseSerialGC:启用 Serial 收集器(单线程)。-XX:+UseParallelGC:启用 Parallel 收集器(多线程,关注吞吐量)。-XX:+UseConcMarkSweepGC:启用 CMS 收集器(低延迟,适合 Web 应用)。-XX:+UseG1GC:启用 G1 收集器(适合大内存应用)。-XX:+UseZGC:启用 ZGC 收集器(超低延迟,适合大内存)。-XX:+UseShenandoahGC:启用 Shenandoah 收集器(超低延迟)。

示例:1

java -XX:+UseG1GC MyApplication

7. 设置 GC 暂停时间目标

-XX:MaxGCPauseMillis=<time>:设置 GC 的最大暂停时间目标(单位为毫秒)。只对 G1 和 ZGC 有效。-XX:GCTimeRatio=<ratio>:设置 GC 时间与应用程序运行时间的比例。例如-XX:GCTimeRatio=19表示 GC 时间占总时间的 1/20。

1 | java -XX:+UseG1GC -XX:MaxGCPauseMillis=200 MyApplication |

8. 监控 JVM 性能

-XX:+HeapDumpOnOutOfMemoryError:当发生 OutOfMemoryError 时自动生成堆转储文件。-XX:HeapDumpPath=<path>:指定堆转储文件的路径。-XX:+PrintCommandLineFlags:打印 JVM 启动时的所有命令行参数。-XX:+PrintFlagsFinal:打印所有 JVM 参数及其最终值。

1 | java -XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=./heapdump.hprof MyApplication |

9. 其他常用参数

-D<property>=<value>:设置系统属性。例如-Dfile.encoding=UTF-8。-server:启用服务器模式(默认情况下大多数 JVM 都会自动启用此模式)。-XX:+DisableExplicitGC:禁用通过System.gc()显式触发的垃圾回收。

1 | java -Dfile.encoding=UTF-8 -server -XX:+DisableExplicitGC MyApplication |

垃圾回收器

1. Serial 收集器

- 工作模式:单线程运行,适用于单核处理器或客户端应用。

- 应用场景:适合内存较小的应用程序,特别是那些对响应时间要求不高且资源有限的环境。

- 优点:实现简单,对于小型应用程序非常有效。

- 缺点:由于是单线程执行,在进行垃圾回收时会暂停所有其他的工作线程(Stop-The-World, STW),这会导致较长时间的停顿。

启用参数:1

-XX:+UseSerialGC

2. Parallel 收集器(也称为 Throughput Collector)

- 工作模式:多线程并行执行,适用于多核处理器环境下的服务器端应用。

- 关注点:提高吞吐量,即减少垃圾回收时间占总运行时间的比例。

- 年轻代:使用标记-复制算法。

- 老年代:使用标记-整理算法。

- 优点:通过并行处理提高了垃圾回收效率,减少了总的停顿时间。

- 缺点:仍然会有较长的停顿时间,特别是在老年代垃圾回收期间。

启用参数:1

-XX:+UseParallelGC

为了优化老年代的收集性能,可以加上 -XX:+UseParallelOldGC 来启用老年代的并行压缩。

3. CMS(Concurrent Mark Sweep)收集器

工作模式:专注于减少停顿时间,尽可能地与应用程序并发执行大部分垃圾回收工作。

主要阶段

:

- 初始标记(Initial Mark)

- 并发标记(Concurrent Mark)

- 再标记(Remark)

- 并发清除(Concurrent Sweep)

优点:尽量减少了应用程序的停顿时间。

缺点:虽然减少了停顿时间,但增加了总体的CPU占用率;无法压缩内存,可能导致内存碎片化问题;在某些情况下可能会导致“Concurrent Mode Failure”。

启用参数:1

-XX:+UseConcMarkSweepGC

4. G1(Garbage First)收集器

设计理念:旨在提供可预测的停顿时间和高吞吐量。G1 将堆划分为多个区域(Region),优先回收垃圾最多的区域。

主要特性

:

- 可以设置最大停顿时间目标。

- 支持大堆内存管理,并能有效避免内存碎片。

- 在进行垃圾回收时,尝试同时清理年轻代和老年代。

优点:相比 CMS,G1 提供了更好的停顿时间控制,并减少了内存碎片的问题。

缺点:配置相对复杂,可能需要更多的调优才能达到最佳效果。

启用参数:1

-XX:+UseG1GC

CAS与原子类

CAS(Compare-And-Swap,比较并交换)是一种重要的原子操作机制,广泛应用于多线程并发控制中。它允许在不使用锁的情况下实现对共享数据的同步访问,从而避免了传统锁机制可能带来的性能瓶颈和死锁问题。CAS操作包含三个参数:内存位置V、预期原值A和新值B。只有当内存位置V的值等于预期原值A时,才会将内存位置V的值更新为新值B,并返回操作是否成功的布尔值;否则,不做任何操作

在 Java 中,java.util.concurrent.atomic 包提供了基于 CAS 的原子类,例如 AtomicInteger、AtomicLong 等。这些类内部使用了 Unsafe 类提供的底层 CAS 操作1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47import java.util.concurrent.atomic.AtomicInteger;

public class CASCounter {

private AtomicInteger value = new AtomicInteger(0); // 使用 AtomicInteger 实现 CAS

// 增加计数器的值

public void increment() {

int current, next;

do {

current = value.get(); // 获取当前值

next = current + 1; // 计算下一个值

} while (!value.compareAndSet(current, next)); // 尝试 CAS 更新

}

// 获取当前计数器的值

public int getValue() {

return value.get();

}

public static void main(String[] args) throws InterruptedException {

CASCounter counter = new CASCounter();

// 创建多个线程并发增加计数器

Thread t1 = new Thread(() -> {

for (int i = 0; i < 1000; i++) {

counter.increment();

}

});

Thread t2 = new Thread(() -> {

for (int i = 0; i < 1000; i++) {

counter.increment();

}

});

// 启动线程

t1.start();

t2.start();

// 等待线程完成

t1.join();

t2.join();

// 输出最终计数器的值

System.out.println("Final counter value: " + counter.getValue());

}

}

乐观锁和悲观锁

乐观锁(Optimistic Locking)和悲观锁(Pessimistic Locking)是两种处理并发控制的策略,它们在如何管理数据冲突方面采取了不同的方法。

乐观锁则假设不会发生并发冲突,因此不会主动加锁。它允许所有事务同时读取并尝试修改数据,但在提交更改前检查是否有其他事务已经修改了相同的数据。如果有,则拒绝此次修改或根据具体业务逻辑进行重试或其他处理。

悲观锁假设会发生并发冲突,因此在操作数据时会直接加锁,防止其他事务对该数据进行修改直到当前事务完成。

使用悲观锁的方式可能是这样的:在处理订单时首先锁定库存记录,然后检查库存是否足够,若足够则扣减库存并提交事务释放锁;否则回滚事务并告知用户库存不足。

使用乐观锁的方式则是:在开始处理订单时不加锁,而是记录下当前库存记录的版本号或时间戳。在准备扣减库存时再次检查版本号或时间戳是否未变,若未变则扣减库存并更新版本号/时间戳;若有变化则表明期间有其他订单已修改了库存,此时可以选择重试或通知用户稍后再试。

原子操作类

- CAS 操作

CAS(Compare-And-Swap)是实现原子操作的核心机制。它是一个低级别的、硬件提供的原子指令,通常用于无锁算法中。一个典型的 CAS 操作包含三个参数:

- 内存位置 V:要更新的数据在内存中的地址。

- 预期值 A:期望在内存位置 V 处找到的值。

- 新值 B:如果内存位置 V 的当前值等于预期值 A,则将该位置的值更新为新值 B。

CAS 操作会检查内存位置 V 的当前值是否与预期值 A 相等。如果相等,则将内存位置 V 更新为新值 B,并返回成功;如果不相等,则不进行任何修改,并返回失败。这个过程是原子性的,意味着在同一时刻只能有一个线程成功执行 CAS 操作。

传统的

AtomicLong(以及AtomicInteger等)使用 CAS(Compare-And-Swap)操作来保证线程安全,但在高并发情况下,多个线程同时竞争同一个值时,CAS 操作可能会频繁失败并重试,导致性能下降。

LongAdder的设计目标是解决这个问题。它通过分段锁的思想将数据分散到多个变量中,减少了线程间的竞争,从而提高了性能。最终结果可以通过这些变量汇总得到。

- Java 内存模型 (JMM)

Java 内存模型定义了多线程环境下变量的可见性和顺序性规则。为了保证线程间共享变量的一致性,Java 提供了 volatile 关键字和同步块 (synchronized) 来确保变量的可见性。原子类内部使用了类似的技术来确保线程间的可见性,即使它们自身并不总是需要显式的同步块。

- Unsafe 类

Java 的原子类内部通常使用 sun.misc.Unsafe 类提供的本地方法来直接调用底层的 CAS 操作。虽然 Unsafe 类并不是官方推荐的 API,但它被广泛应用于高性能并发库中,如 java.util.concurrent 包内的实现。通过 Unsafe,开发者可以绕过 Java 的安全检查直接与操作系统交互,这使得它可以非常高效地执行 CAS 操作。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16import java.util.concurrent.atomic.AtomicInteger;

public class AtomicIntegerExample {

public static void main(String[] args) {

AtomicInteger atomicInt = new AtomicInteger(0);

// 原子递增

System.out.println("Initial value: " + atomicInt.get());

atomicInt.incrementAndGet(); // 自增1

System.out.println("After increment: " + atomicInt.get());

// 原子更新

atomicInt.updateAndGet(x -> x * 2); // 使用函数式更新

System.out.println("After update: " + atomicInt.get());

}

}

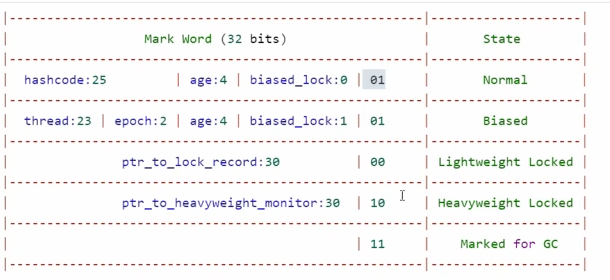

synchronized优化

偏向锁

偏向锁的设计初衷是为了消除无竞争情况下的同步原语,进一步提高程序的运行性能。当一个线程访问同步块并获取锁时,会在对象头中记录当前线程的ID,表示该线程占有了这个对象的锁。

当大多数情况下锁不仅不存在多线程竞争,而且总是由同一线程多次获得时,使用偏向锁可以减少不必要的同步操作。

特性:当没有其他线程尝试获取同一个锁时,持有偏向锁的线程不需要进行同步操作。

如果有其他线程尝试获取偏向锁,则会发生偏向锁撤销,锁可能会升级为轻量级锁。

轻量级锁

Java 轻量级锁是 JVM 提供的一种优化机制,旨在减少多线程环境下获取锁的开销。它主要通过使用 CAS(Compare-And-Swap)操作来避免传统锁带来的性能损耗,适用于线程竞争较少的情况。轻量级锁是 Java 锁机制的一部分,它可以动态升级为重量级锁以应对更高的竞争情况。

- 在线程交替执行同步块且存在轻微的竞争时,轻量级锁能够通过CAS(Compare-and-Swap)操作来避免线程阻塞和上下文切换。

- 特性

- 每个线程都有自己的栈帧,其中包含用于存储锁的记录空间(Lock Record)。当线程试图获取轻量级锁时,会将对象头中的Mark Word复制到该线程的锁记录中,并尝试通过CAS操作将对象头指向该线程的锁记录。

- 若多个线程同时请求轻量级锁且自旋一定次数后仍未成功获取锁,则锁将膨胀为重量级锁。

轻量级锁的工作原理

- 加锁过程

- 当一个线程尝试获取锁时,如果对象没有被锁定(锁标志位为“01”),JVM 会在当前线程的栈帧中创建一个称为 Lock Record 的空间,并将对象头中的 Mark Word 复制到这个 Lock Record 中。

- 然后,线程会尝试用 CAS 操作将对象头中的 Mark Word 更新为指向该线程 Lock Record 的指针。如果成功,则该线程获得了锁。

- 如果 CAS 操作失败,意味着另一个线程已经持有了锁,这时当前线程会自旋(忙等)一段时间,尝试重新获取锁。

- 解锁过程

- 当线程退出同步块时,会使用 CAS 操作尝试将对象头中的 Mark Word 恢复为其原始值(即从 Lock Record 中拷贝回来的 Displaced Mark Word)。

- 如果 CAS 操作成功,则表示没有其他线程尝试获取该锁,锁被成功释放。

- 如果 CAS 操作失败,说明有其他线程尝试获取过该锁,此时轻量级锁将会膨胀为重量级锁。

- 锁的升级

- 轻量级锁在遇到高竞争(即多个线程频繁尝试获取同一把锁)的情况下,可能会膨胀为重量级锁。这是因为持续的自旋等待会消耗大量的 CPU 资源。

- 一旦锁升级为重量级锁,后续试图获取锁的线程将进入阻塞状态,直到锁被释放。

- 适用场景

- 轻量级锁适用于线程竞争不激烈、锁占用时间较短的情况。在这种情况下,轻量级锁能够通过 CAS 操作和自旋来避免线程的阻塞和上下文切换,从而提高程序的并发性能。

- 对于锁竞争较为激烈的场景,建议使用 ReentrantLock 或者其他的高级同步机制,因为这些机制提供了更灵活的锁管理和更好的性能表现。

重量锁

重量级锁通过操作系统提供的互斥量(mutex)来实现线程间的同步,这种锁会让线程调用者进入阻塞状态,并被操作系统挂起。

在高竞争环境下,即多个线程频繁争夺同一资源时,重量级锁能够确保数据的一致性和完整性。

特性

- 锁住的线程会被挂起直到锁被释放,此时其他等待的线程才有可能获取锁。

- 由于涉及用户态到内核态的切换以及线程的挂起和唤醒,重量级锁的开销较大。

锁膨胀

锁膨胀(Lock Escalation)在Java中通常指的是synchronized关键字背后的锁机制随着竞争条件的变化而动态升级的过程。具体来说,在Java虚拟机(JVM)中,锁的状态可以经历从无锁状态到偏向锁、轻量级锁,最后到重量级锁的转变过程。这个过程称为锁膨胀或锁升级,并且它是一个单向的过程,即锁只能从低级别向高级别升级,不能降级。

锁膨胀的具体过程:

- 无锁状态:当对象刚创建时,没有线程尝试获取该对象上的锁,此时处于无锁状态。

- 偏向锁状态:当第一个线程尝试获取对象上的锁时,JVM会将锁设置为偏向锁,并记录下持有偏向锁的线程ID。如果之后还是同一个线程访问,则不需要再次进行加锁操作,直接进入同步块执行代码。偏向锁的目标是减少无实际竞争情况下的锁获取成本。

- 轻量级锁状态:如果有第二个线程尝试获取已经被偏向锁持有的对象的锁时,偏向锁会升级为轻量级锁。轻量级锁使用CAS(Compare and Swap)操作来尝试获取锁,以减少锁的竞争和系统的开销。轻量级锁适用于多个线程交替执行同步块的情况。

- 重量级锁状态:当多个线程长时间竞争同一个对象的锁时,轻量级锁会升级为重量级锁。重量级锁采用操作系统的互斥量(Mutex)来实现,确保线程的安全性。在这种状态下,JVM会创建一个等待队列,将等待获取锁的线程挂起在队列中。重量级锁会导致较大的性能开销,因为它涉及到用户态与内核态之间的切换。

锁膨胀的设计目的是为了优化多线程环境下的性能。通过这种方式,JVM可以根据不同的并发场景自动调整锁的状态,从而减少不必要的性能损耗。例如,在几乎没有竞争的情况下,偏向锁可以提供很好的性能;而在有少量竞争的情况下,轻量级锁可以通过自旋避免阻塞,提高效率;只有在高竞争的情况下,才会升级为重量级锁。这种机制使得synchronized在大多数情况下都能够高效运行。

其他优化

- 减少上锁时间

- 减少锁的颗粒度 使用concurrentHashMap

- 锁粗化 多次循环进入同步块不如在同步块内进行循环

- 锁消除

- 读写分离

JUC

创建线程

1. 继承 Thread 类

(1) 基本原理

通过继承 Thread 类并重写 run() 方法,调用 start() 方法启动线程。

(2) 示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16class MyThread extends Thread {

public void run() {

System.out.println("Thread running: " + Thread.currentThread().getName());

}

}

public class Main {

public static void main(String[] args) {

MyThread thread1 = new MyThread();

MyThread thread2 = new MyThread();

thread1.start(); // 启动线程

thread2.start(); // 启动线程

}

}

(3) 优点

- 简单直观,易于理解。

(4) 缺点

Java 不支持多重继承,如果一个类已经继承了其他类,则无法再继承

Thread。2. 实现

Runnable接口

(1) 基本原理

通过实现 Runnable 接口并实现 run() 方法,将 Runnable 对象传递给 Thread 构造器来启动线程。

(2) 示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16class MyRunnable implements Runnable {

public void run() {

System.out.println("Runnable running: " + Thread.currentThread().getName());

}

}

public class Main {

public static void main(String[] args) {

Thread thread1 = new Thread(new MyRunnable());

Thread thread2 = new Thread(new MyRunnable());

thread1.start(); // 启动线程

thread2.start(); // 启动线程

}

}

(3) 优点

- 更灵活:可以避免因为继承

Thread而导致的多重继承问题。 - 适合资源共享(多个线程共享同一个

Runnable实例)。

(4) 缺点

- 需要显式地将

Runnable对象传递给Thread。

3. 使用 Callable 和 FutureTask

(1) 基本原理

Callable 接口类似于 Runnable,但它可以返回结果,并且可以抛出异常。FutureTask 是一个包装类,用于管理 Callable 的执行结果。

(2) 示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27import java.util.concurrent.Callable;

import java.util.concurrent.FutureTask;

class MyCallable implements Callable<Integer> {

public Integer call() throws Exception {

System.out.println("Callable running: " + Thread.currentThread().getName());

return 42; // 返回计算结果

}

}

public class Main {

public static void main(String[] args) throws Exception {

FutureTask<Integer> futureTask1 = new FutureTask<>(new MyCallable());

FutureTask<Integer> futureTask2 = new FutureTask<>(new MyCallable());

Thread thread1 = new Thread(futureTask1);

Thread thread2 = new Thread(futureTask2);

thread1.start();

thread2.start();

// 获取线程执行结果

System.out.println("Result from thread1: " + futureTask1.get());

System.out.println("Result from thread2: " + futureTask2.get());

}

}

(3) 优点

- 可以返回结果。

- 可以捕获线程中的异常。

- 适合需要获取线程执行结果的场景。

(4) 缺点

- 相比

Runnable,代码稍微复杂一些。

4. 使用线程池(推荐)

(1) 基本原理

Java 提供了 ExecutorService 接口和 Executors 工厂类,用于管理和复用线程,避免频繁创建和销毁线程带来的开销。

(2) 示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

class Task implements Runnable {

private String name;

public Task(String name) {

this.name = name;

}

public void run() {

System.out.println("Executing task: " + name + " in thread: " + Thread.currentThread().getName());

}

}

public class Main {

public static void main(String[] args) {

ExecutorService executor = Executors.newFixedThreadPool(3); // 创建固定大小的线程池

for (int i = 0; i < 5; i++) {

executor.submit(new Task("Task-" + i));

}

executor.shutdown(); // 关闭线程池

}

}

(3) 优点

- 高效:线程池可以复用线程,减少线程创建和销毁的开销。

- 灵活:可以设置线程池大小、任务队列等。

- 易于管理:提供更高级的任务调度和生命周期管理功能。

(4) 缺点

- 初学者可能觉得使用线程池的 API 比较复杂。

5. 使用 Lambda 表达式(简化代码)

从 Java 8 开始,可以使用 Lambda 表达式进一步简化线程的创建和使用。

(1) 示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17public class Main {

public static void main(String[] args) {

// 使用 Lambda 表达式实现 Runnable

Thread thread1 = new Thread(() ->

System.out.println("Lambda thread running: " + Thread.currentThread().getName())

);

// 使用 Lambda 表达式提交任务到线程池

ExecutorService executor = Executors.newSingleThreadExecutor();

executor.submit(() ->

System.out.println("Lambda task running: " + Thread.currentThread().getName())

);

thread1.start();

executor.shutdown();

}

}

(2) 优点

- 简洁:减少了样板代码。

- 易读:代码更加紧凑。

6. 总结与选择建议

| 方法 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|

继承 Thread 类 | 简单任务,快速验证 | 简单直观 | 不能多重继承 |

实现 Runnable 接口 | 多线程共享资源 | 灵活,避免多重继承限制 | 需要显式传递 Runnable |

使用 Callable 和 FutureTask | 需要返回结果或处理异常的任务 | 支持返回值和异常处理 | 代码稍微复杂 |

| 使用线程池 | 长时间运行的任务,或者需要高效管理线程的场景 | 高效,易于管理 | API 较复杂 |

| 使用 Lambda 表达式 | 简化代码,尤其是在线程池中 | 代码简洁 | 依赖 Java 8+ |

Syncronized优化原理

synchronized 的底层实现依赖于 JVM 提供的监视器锁(Monitor)\机制,而监视器锁最终映射到操作系统提供的*互斥锁(Mutex Lock)*。具体来说,synchronized 的工作原理分为以下几个阶段:

(1) Monitor(监视器)

- 每个 Java 对象都有一个与之关联的监视器(Monitor),也称为“内置锁”或“监视器锁”。

- 监视器的作用是确保同一时刻只有一个线程能够持有该锁并执行同步代码。

(2) 对象头中的 Mark Word

- 在 HotSpot 虚拟机中,每个 Java 对象都有一个对象头(Object Header),其中包含一个

Mark Word。 Mark Word用来存储对象的元信息,例如哈希码、GC 分代年龄、锁状态等。- 当线程尝试获取锁时,

Mark Word的内容会动态变化,表示锁的状态(无锁、偏向锁、轻量级锁、重量级锁)。

(3) 锁的升级机制

为了优化性能,synchronized 实现了锁的升级机制,从低开销的锁逐步升级到高开销的锁。锁的升级过程如下:

- 无锁状态:

- 初始状态下,对象没有被任何线程锁定。

- 偏向锁(Biased Locking):

- 如果某个线程多次进入同步代码块,JVM 会将锁偏向于该线程。

- 偏向锁通过在

Mark Word中记录线程 ID 来实现,避免每次加锁和解锁都需要 CAS(Compare-And-Swap)操作。 - 偏向锁适用于单线程访问同步代码块的场景。

- 轻量级锁(Lightweight Locking):

- 当有多个线程竞争同一个锁时,偏向锁会升级为轻量级锁。

- 轻量级锁使用自旋的方式尝试获取锁,减少线程上下文切换的开销。

- 如果自旋成功,则直接获取锁;如果自旋失败,则升级为重量级锁。

- 重量级锁(Heavyweight Locking):

- 当竞争激烈时,轻量级锁会升级为重量级锁。

- 重量级锁依赖于操作系统的互斥锁(Mutex Lock),会导致线程阻塞和唤醒,开销较大。

(4) 锁的释放

- 当线程退出同步代码块时,会释放锁。

- JVM 会根据锁的状态(偏向锁、轻量级锁、重量级锁)进行相应的处理,恢复对象头的

Mark Word状态。

| 特性 | synchronized | ReentrantLock |

|---|---|---|

| 实现方式 | JVM 内置关键字 | 显式锁,API 实现 |

| 锁优化 | 支持偏向锁、轻量级锁 | 不支持 |

| 公平性 | 非公平锁 | 支持公平锁 |

| 可中断性 | 不支持 | 支持 |

| 超时机制 | 不支持 | 支持 |

| 条件变量 | 不支持 | 支持(通过 Condition) |

ReentrantLock

ReentrantLock 是 Java 提供的一种可重入的互斥锁,它位于 java.util.concurrent.locks 包中,是 Lock 接口的一个实现类。相比于 synchronized 关键字,ReentrantLock 提供了更灵活、更强大的锁机制,适用于复杂的并发场景。

可重入锁(Reentrant Lock) 指的是一个线程可以多次获取同一个锁而不被自己阻塞。这意味着如果一个线程已经持有了某个锁,并尝试再次获取该锁,则该操作会成功,而不是导致死锁。每次获取锁时,锁内部的计数器会增加;每次释放锁时,计数器会减少;只有当计数器归零时,锁才会真正被释放,允许其他线程获取。

可重入

1 | import java.util.concurrent.locks.ReentrantLock; |

可打断

“可打断”(Interruptible)指的是线程在等待某种资源或处于阻塞状态时,是否能够响应中断请求并进行相应的处理.当一个线程处于不可打断的状态下(如通过某些同步机制等待获取锁),它将不会响应中断信号;而在可打断状态下,线程可以捕获到中断请求,并根据应用逻辑决定如何处理这个中断.1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51import java.util.concurrent.locks.ReentrantLock;

public class InterruptibleLockExample {

private final ReentrantLock lock = new ReentrantLock();

public void performTask() throws InterruptedException {

try {

System.out.println(Thread.currentThread().getName() + " is trying to acquire the lock.");

// 尝试获取锁,但是可以响应中断

lock.lockInterruptibly();

try {

System.out.println(Thread.currentThread().getName() + " has acquired the lock.");

// 模拟任务处理

Thread.sleep(5000);

} finally {

lock.unlock();

}

} catch (InterruptedException e) {

System.out.println(Thread.currentThread().getName() + " was interrupted while waiting for the lock.");

// 处理中断,通常这里需要做一些清理工作

Thread.currentThread().interrupt(); // 重新设置中断标志

}

}

public static void main(String[] args) throws InterruptedException {

InterruptibleLockExample example = new InterruptibleLockExample();

Thread t1 = new Thread(() -> {

try {

example.performTask();

} catch (InterruptedException e) {

e.printStackTrace();

}

}, "Worker-1");

Thread t2 = new Thread(() -> {

try {

Thread.sleep(1000); // 让 t1 先开始尝试获取锁

example.performTask();

} catch (InterruptedException e) {

e.printStackTrace();

}

}, "Worker-2");

t1.start();

t2.start();

Thread.sleep(2000); // 主线程等待一段时间后中断 t2

t2.interrupt();

}

}

尝试获取锁

boolean tryLock()- 尝试获取锁。如果锁可用,则立即获取并返回

true;否则返回false。

- 尝试获取锁。如果锁可用,则立即获取并返回

boolean tryLock(long timeout, TimeUnit unit)- 尝试在指定时间内获取锁。如果在超时前获取到锁,则返回

true;否则返回false。

- 尝试在指定时间内获取锁。如果在超时前获取到锁,则返回

公平锁

ReentrantLock 默认是非公平锁。也就是说,当多个线程竞争锁时,默认情况下新来的线程可能会直接插队获取锁,而不需要严格按照线程等待的顺序(FIFO 队列)来分配锁。

公平锁与非公平锁的区别

- 公平锁(Fair Lock)

- 公平锁会按照线程请求锁的顺序(即 FIFO 队列)来分配锁。

- 这种方式可以避免线程饥饿问题,但可能会导致性能下降,因为线程切换的开销较高。

- 非公平锁(Non-Fair Lock)

- 非公平锁允许插队,即新来的线程可以直接尝试获取锁,而不需要排队。

- 这种方式减少了线程上下文切换的开销,提高了吞吐量,但在高并发场景下可能导致某些线程长时间无法获取锁(饥饿问题)。

与条件变量

在并发编程中,条件变量是一种用于线程间协调的机制。它允许一个或多个线程等待某个条件变为真,而不是忙等(busy-waiting)。在Java中,Condition 接口由 ReentrantLock 类提供支持,每个 ReentrantLock 可以创建多个 Condition 实例,从而实现更加灵活的线程控制。

Condition 接口的主要方法

- await():使当前线程等待,并释放锁。直到其他线程调用

signal()或signalAll()方法唤醒它。 - signal():唤醒一个等待该条件的线程。如果有多个线程在等待,则选择其中的一个。

- signalAll():唤醒所有等待该条件的线程。

- awaitUninterruptibly():类似于

await(),但是不会响应中断。 - awaitNanos(long nanosTimeout)、awaitUntil(Date deadline):带超时的等待方法。

1 | import java.util.concurrent.locks.Condition; |

volatile原理

volatile 是 Java 中的一个关键字,用于修饰变量,它提供了一种比锁更轻量级的同步机制。尽管 volatile 并不能替代 synchronized 关键字所提供的所有功能,但在某些特定场景下,它可以有效地保证线程间的可见性和有序性。

工作原理

- 可见性:当一个线程对一个

volatile变量进行写操作时,会将该变量立即刷新到主内存中。而当其他线程读取这个volatile变量时,它们会被强制从主内存中重新读取这个变量的最新值,而不是使用自己工作内存中的缓存副本。这就确保了所有线程都能看到最新的变量值。 - 禁止指令重排序优化:Java 编译器和处理器可以对指令进行重排序以提高执行效率。然而,这种重排序可能会导致多线程环境下的程序出现意料之外的行为。

volatile变量可以防止编译器对涉及该变量的操作进行指令重排序,从而保持代码的预期执行顺序。

虽然 volatile 和原子类(如 AtomicInteger)都提供了线程安全的操作,但它们之间存在一些关键差异:

- 原子性:

volatile只能保证变量的可见性和有序性,不能保证复合操作(比如增加、减少)的原子性。而原子类通过使用 CAS(比较并交换)等硬件级别的原子操作来保证操作的原子性。 - 性能:由于

volatile不需要像锁那样复杂的开销,因此在只涉及简单状态更新的情况下,它的性能通常优于基于锁的解决方案。但是,在需要进行复杂的状态转换或需要保证原子性的场景下,原子类可能是更好的选择。

1 | public class FlagExample { |

volatile 适用于以下场景:

- 变量的写入不依赖于其当前值。

- 变量不需要与其他状态变量共同参与不变约束。

- 对变量的访问都是原子操作(例如,简单的布尔标志)。

自定义线程池

1 | class ThreadPool { |

使用JDK提供的方法1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47import java.util.concurrent.*;

public class ThreadPoolExample {

public static void main(String[] args) {

// 核心线程数

int corePoolSize = 2;

// 最大线程数

int maximumPoolSize = 4;

// 空闲线程存活时间

long keepAliveTime = 10;

// 时间单位

TimeUnit unit = TimeUnit.SECONDS;

// 任务队列

BlockingQueue<Runnable> workQueue = new LinkedBlockingQueue<>(2);

// 线程工厂

ThreadFactory threadFactory = Executors.defaultThreadFactory();

// 拒绝策略

RejectedExecutionHandler handler = new ThreadPoolExecutor.AbortPolicy();

// 创建线程池

ThreadPoolExecutor executor = new ThreadPoolExecutor(

corePoolSize,

maximumPoolSize,

keepAliveTime,

unit,

workQueue,

threadFactory,

handler

);

// 提交任务

for (int i = 0; i < 10; i++) {

final int taskId = i;

executor.submit(() -> {

System.out.println("Task " + taskId + " is running on thread " + Thread.currentThread().getName());

try {

Thread.sleep(2000); // 模拟任务执行

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

}

// 关闭线程池

executor.shutdown();

}

}1

2

3

4

5

6

7

8

9

10

11

12ThreadPoolExecutor threadPoolExecutor = new ThreadPoolExecutor(1, 1, 0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>(), new ThreadPoolExecutor.DiscardPolicy());

for (int i = 0; i < 10; i++) {

Future<Integer> submit = threadPoolExecutor.submit(new MyCallable());

try {

System.out.println(submit.get());

} catch (InterruptedException e) {

throw new RuntimeException(e);

} catch (ExecutionException e) {

throw new RuntimeException(e);

}

}

- corePoolSize:

- 核心线程数,即线程池中始终保持的最小线程数量。

- 即使这些线程处于空闲状态,也不会被销毁(除非设置了

allowCoreThreadTimeOut)。

- maximumPoolSize:

- 线程池允许的最大线程数。

- 当任务队列已满且当前线程数小于

maximumPoolSize时,线程池会创建新线程来处理任务。

- keepAliveTime:

- 空闲线程的存活时间。

- 如果线程数超过

corePoolSize,多余的空闲线程会在空闲一段时间后被回收。

- unit:

keepAliveTime的时间单位,例如TimeUnit.SECONDS。

- workQueue:

- 任务队列,用于保存等待执行的任务。

- 常见实现包括:

ArrayBlockingQueue:有界队列。LinkedBlockingQueue:无界队列。SynchronousQueue:不存储任务,直接交给线程执行。

- threadFactory:

- 创建线程的工厂,用于自定义线程的名称、优先级等属性。

- 默认使用

Executors.defaultThreadFactory()。

- handler:

- 拒绝策略,当线程池无法处理新任务时(例如线程池已满且任务队列已满),会调用此策略。

- 常见实现包括:

AbortPolicy:抛出RejectedExecutionException异常。CallerRunsPolicy:由调用线程(提交任务的线程)执行该任务。DiscardPolicy:直接丢弃任务。DiscardOldestPolicy:丢弃队列中最旧的任务,然后尝试重新提交新任务。

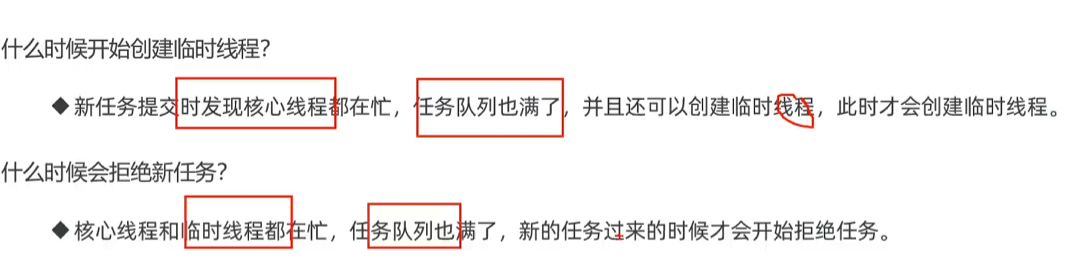

3. 线程池的工作原理

- 任务提交:

- 当一个任务被提交到线程池时,线程池会根据当前线程数和任务队列的状态决定如何处理任务。

- 任务分配逻辑:

- 如果当前线程数小于

corePoolSize,即使有空闲线程,也会创建新线程来执行任务。 - 如果当前线程数等于或大于

corePoolSize,任务会被放入任务队列中等待。 - 如果任务队列已满且当前线程数小于

maximumPoolSize,线程池会创建新线程来执行任务。 - 如果任务队列已满且当前线程数等于

maximumPoolSize,则触发拒绝策略。

- 如果当前线程数小于

- 线程回收:

- 如果线程数超过

corePoolSize,多余的空闲线程会在空闲一段时间(keepAliveTime)后被回收

- 如果线程数超过

Executors

- 创建固定大小的线程池 -

newFixedThreadPool

该方法返回一个固定大小的线程池,适用于需要限制并发线程数的场景。

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class FixedThreadPoolExample {

public static void main(String[] args) {

// 创建一个固定大小为3的线程池

ExecutorService fixedThreadPool = Executors.newFixedThreadPool(3);

for (int i = 0; i < 5; i++) {

int taskId = i;

fixedThreadPool.submit(() -> {

System.out.println("Task " + taskId + " is running on thread " + Thread.currentThread().getName());

try {

Thread.sleep(2000); // 模拟任务执行时间

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

}

// 关闭线程池

fixedThreadPool.shutdown();

}

}

- 线程池中的线程数量是固定的。

- 如果所有线程都在忙,新的任务将等待直到有空闲线程可用。

- 创建单线程化的线程池 -

newSingleThreadExecutor

该方法返回一个只有一个工作线程的线程池,适用于需要保证顺序执行任务的场景。

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class SingleThreadExecutorExample {

public static void main(String[] args) {

// 创建一个单线程化的线程池

ExecutorService singleThreadExecutor = Executors.newSingleThreadExecutor();

for (int i = 0; i < 5; i++) {

int taskId = i;

singleThreadExecutor.submit(() -> {

System.out.println("Task " + taskId + " is running on thread " + Thread.currentThread().getName());

try {

Thread.sleep(2000); // 模拟任务执行时间

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

}

// 关闭线程池

singleThreadExecutor.shutdown();

}

}

- 所有提交的任务按照提交顺序依次执行。

- 即使发生故障,也会重新创建一个线程来替代原来的线程继续处理后续任务。

- 创建一个会根据需要创建新线程的线程池 -

newCachedThreadPool

该方法返回一个可根据需要创建新线程的线程池,适用于执行大量短期异步任务的场景。

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class CachedThreadPoolExample {

public static void main(String[] args) {

// 创建一个缓存线程池

ExecutorService cachedThreadPool = Executors.newCachedThreadPool();

for (int i = 0; i < 5; i++) {

final int taskId = i;

cachedThreadPool.submit(() -> {

System.out.println("Task " + taskId + " is running on thread " + Thread.currentThread().getName());

try {

Thread.sleep(2000); // 模拟任务执行时间

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

}

// 关闭线程池

cachedThreadPool.shutdown();

}

}

- 线程池可以根据需要创建新线程,并在空闲60秒后回收未使用的线程。

- 适合执行大量短期异步任务的应用程序。

- 创建支持定时及周期性任务执行的线程池 -

newScheduledThreadPool

该方法返回一个支持定时和周期性任务执行的线程池。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23import java.util.concurrent.Executors;

import java.util.concurrent.ScheduledExecutorService;

import java.util.concurrent.TimeUnit;

public class ScheduledThreadPoolExample {

public static void main(String[] args) {

// 创建一个支持定时及周期性任务执行的线程池

ScheduledExecutorService scheduledThreadPool = Executors.newScheduledThreadPool(3);

// 定时执行任务,延迟2秒后执行

scheduledThreadPool.schedule(() -> {

System.out.println("This task is run after a delay of 2 seconds");

}, 2, TimeUnit.SECONDS);

// 周期性执行任务,初始延迟2秒后开始执行,之后每隔3秒执行一次

scheduledThreadPool.scheduleAtFixedRate(() -> {

System.out.println("This task is run periodically every 3 seconds");

}, 2, 3, TimeUnit.SECONDS);

// 记得关闭线程池

// scheduledThreadPool.shutdown(); 在实际应用中,可能需要在适当的时候调用shutdown()来关闭线程池

}

}

- 支持延迟执行任务或周期性执行任务。

schedule()方法用于一次性延迟执行任务。scheduleAtFixedRate()方法用于周期性执行任务。

- 使用自定义线程工厂

你可以通过提供自定义的 ThreadFactory 来定制线程的创建过程,比如设置线程名称、优先级等。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28import java.util.concurrent.*;

public class CustomThreadFactoryExample {

public static void main(String[] args) {

ThreadFactory customThreadFactory = new ThreadFactory() {

public Thread newThread(Runnable r) {

return new Thread(r, "CustomThread-" + System.currentTimeMillis());

}

};

ExecutorService executorService = Executors.newFixedThreadPool(2, customThreadFactory);

for (int i = 0; i < 5; i++) {

int taskId = i;

executorService.submit(() -> {

System.out.println("Task " + taskId + " is running on thread " + Thread.currentThread().getName());

try {

Thread.sleep(2000); // 模拟任务执行时间

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

}

executorService.shutdown();

}

}

自定义线程工厂允许更灵活地控制线程的创建过程。

线程池关闭方法

shutdown()

- 描述:该方法不会立即强制关闭线程池,而是首先停止接收新的任务,并尝试完成已经提交的任务。

- 行为

- 已经提交到线程池中的任务将继续执行直至完成。

- 此方法调用后,如果尝试向线程池提交新任务,则会根据线程池的拒绝策略处理(通常是抛出

RejectedExecutionException)。

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class ShutdownExample {

public static void main(String[] args) throws InterruptedException {

ExecutorService executor = Executors.newFixedThreadPool(2);

for (int i = 0; i < 5; i++) {

int taskId = i;

executor.submit(() -> {

System.out.println("Task " + taskId + " is running on thread " + Thread.currentThread().getName());

try {

Thread.sleep(2000); // 模拟任务执行时间

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

}

System.out.println("Shutting down the executor...");

executor.shutdown(); // 发出关闭信号

// 等待所有任务完成

if (!executor.awaitTermination(60, TimeUnit.SECONDS)) {

System.out.println("Some tasks are still running");

} else {

System.out.println("All tasks finished.");

}

}

}

shutdownNow()

- 描述:尝试立即停止所有正在执行的任务,并暂停处理等待的任务。

- 行为

- 它试图终止所有正在执行的任务,并返回一个等待执行的任务列表。

- 并不能保证能够立即停止正在执行的任务,因为任务可能无法响应中断。

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27import java.util.List;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class ShutdownNowExample {

public static void main(String[] args) throws InterruptedException {

ExecutorService executor = Executors.newFixedThreadPool(2);

for (int i = 0; i < 5; i++) {

int taskId = i;

executor.submit(() -> {

try {

System.out.println("Task " + taskId + " is running on thread " + Thread.currentThread().getName());

Thread.sleep(2000); // 模拟任务执行时间

} catch (InterruptedException e) {

System.out.println("Task " + taskId + " was interrupted.");

Thread.currentThread().interrupt(); // 重新设置中断状态

}

});

}

System.out.println("Attempting to shutdown the executor now...");

List<Runnable> notExecutedTasks = executor.shutdownNow(); // 尝试立即关闭

System.out.println("Number of tasks that will not be executed: " + notExecutedTasks.size());

}

}

awaitTermination(long timeout, TimeUnit unit)

- 描述:阻塞当前线程直到线程池中的所有任务都已完成执行,或者超时发生,或者当前线程被中断。

- 行为

- 通常与

shutdown()方法一起使用,以确保所有任务都在程序退出之前完成。 - 返回值为

true表示所有任务都已经完成;返回false则表示由于超时而未完成。

- 通常与

可以通过调用 isShutdown() 方法来检查线程池是否已经被标记为关闭。此外,isTerminated() 可用于判断线程池是否已经完全终止(即所有任务都已完成)

线程安全集合类

线程安全的集合类是用于在多线程环境中安全地存储和操作数据的工具。这些集合类通过内部的同步机制或无锁算法(如 CAS)来保证线程安全。

Vector 和 Hashtable

这两个类是早期 Java 提供的线程安全集合类,但现在已被更高效的替代品取代。

Vector

- 线程安全的动态数组,类似于

ArrayList,但所有操作都通过synchronized加锁。 - 性能较低,推荐使用

CopyOnWriteArrayList或Collections.synchronizedList()替代。

Hashtable

- 线程安全的哈希表,类似于

HashMap,但所有操作都通过synchronized加锁。 - 推荐使用

ConcurrentHashMap替代。

同步包装类(Collections.synchronizedXxx() 方法)

Java 的 Collections 类提供了一组静态方法,可以将普通的非线程安全集合包装成线程安全的集合。

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18import java.util.*;

public class SynchronizedCollectionsExample {

public static void main(String[] args) {

// 创建一个线程安全的 ArrayList

List<String> synchronizedList = Collections.synchronizedList(new ArrayList<>());

// 创建一个线程安全的 HashMap

Map<String, String> synchronizedMap = Collections.synchronizedMap(new HashMap<>());

// 使用时仍需手动加锁以保证复合操作的线程安全

synchronized (synchronizedList) {

if (!synchronizedList.isEmpty()) {

synchronizedList.remove(0);

}

}

}

}

特点

- 内部通过

synchronized关键字实现同步。 - 简单易用,但性能较差,因为所有操作都需要竞争同一把锁。

- 复合操作(如迭代、条件检查等)需要外部手动加锁。

Concurrent 系列集合

java.util.concurrent 包中提供了多个高性能的线程安全集合类,它们基于分段锁(Segment Lock)或其他无锁算法(如 CAS),性能优于传统的同步集合。

常用类

ConcurrentHashMap:- 线程安全的

Map实现。 - 支持高并发访问,性能优于

Hashtable。 - 内部通过分段锁或 CAS 操作实现线程安全。

- 线程安全的

ConcurrentSkipListMap:- 线程安全的有序

Map实现。 - 基于跳表(Skip List)实现。

- 线程安全的有序

ConcurrentSkipListSet:- 线程安全的有序

Set实现。

- 线程安全的有序

ConcurrentLinkedQueue:- 线程安全的无界非阻塞队列。

- 基于链表实现,支持高并发。

ConcurrentLinkedDeque:- 线程安全的双端队列。

1 | import java.util.concurrent.ConcurrentHashMap; |

特点

- 高性能,支持高并发。

- 提供了丰富的原子操作(如

computeIfAbsent、merge等)。 - 适用于高并发场景。

阻塞队列(Blocking Queue)

阻塞队列是线程安全的队列,当队列为空或满时,会阻塞线程直到满足条件。

常用类

ArrayBlockingQueue:- 有界阻塞队列,基于数组实现。

- 需要指定容量。

LinkedBlockingQueue:- 无界或有界阻塞队列,基于链表实现。

- 默认情况下是无界的(容量为

Integer.MAX_VALUE)。

PriorityBlockingQueue:- 线程安全的优先级队列。

- 元素按优先级排序。

SynchronousQueue:- 不存储元素的阻塞队列。

- 每次插入操作必须等待一个对应的移除操作。

DelayQueue:- 用于延迟处理元素的阻塞队列。

- 元素只有在延迟时间到期后才能被取出。

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36import java.util.concurrent.ArrayBlockingQueue;

import java.util.concurrent.BlockingQueue;

public class BlockingQueueExample {

public static void main(String[] args) throws InterruptedException {

BlockingQueue<String> queue = new ArrayBlockingQueue<>(2);

// 生产者线程

Thread producer = new Thread(() -> {

try {

queue.put("A");

queue.put("B");

queue.put("C"); // 队列满时阻塞

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

// 消费者线程

Thread consumer = new Thread(() -> {

try {

System.out.println(queue.take());

System.out.println(queue.take());

System.out.println(queue.take()); // 队列空时阻塞

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

producer.start();

consumer.start();

producer.join();

consumer.join();

}

}

特点

- 适用于生产者-消费者模型。

- 提供了阻塞操作(如

put和take)。 - 可以控制队列的容量。

CopyOnWrite 系列集合

CopyOnWrite 系列集合适用于读多写少的场景,其核心思想是:每次修改时复制一份新的数据副本,从而避免读写冲突。

常用类

CopyOnWriteArrayList:- 线程安全的

List实现。 - 适用于读操作远多于写操作的场景。

- 线程安全的

CopyOnWriteArraySet:- 基于

CopyOnWriteArrayList实现的线程安全Set。

- 基于

示例代码1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17import java.util.List;

import java.util.concurrent.CopyOnWriteArrayList;

public class CopyOnWriteArrayListExample {

public static void main(String[] args) {

List<String> list = new CopyOnWriteArrayList<>();

// 添加元素

list.add("A");

list.add("B");

// 遍历(无需额外加锁)

for (String item : list) {

System.out.println(item);

}

}

}

特点

- 修改操作(如

add、remove)会创建数据副本,因此写操作成本较高。 - 读操作不需要加锁,性能高。

- 不适合频繁写入的场景。

| 集合类型 | 场景 | 特点 |

|---|---|---|

Collections.synchronizedXxx() | 简单线程安全需求 | 所有操作加锁,性能较低 |

Vector / Hashtable | 兼容旧代码 | 过时,不推荐 |

CopyOnWriteArrayList | 读多写少 | 写操作成本高,读操作无需加锁 |

ConcurrentHashMap | 高并发场景 | 高性能,支持原子操作 |

阻塞队列(如 ArrayBlockingQueue) | 生产者-消费者模型 | 提供阻塞操作,支持容量控制 |

FAQ

HashMap并发死链问题

HashMap 的底层实现是一个数组(桶)和链表/红黑树的结合。当发生哈希冲突时,多个键值对会被存储在同一个桶中,形成链表或红黑树。在多线程环境下,如果多个线程同时对 HashMap 进行写操作(如扩容或插入),可能会破坏链表的结构,导致链表形成环状结构(即死链)。

具体原因:

- 扩容时的并发问题

- 当

HashMap的容量不足时,会触发扩容操作(resize()方法),将旧数组中的元素重新分配到新数组中。 - 在多线程环境下,多个线程可能同时执行扩容操作,导致链表节点被错误地连接,形成环形链表。

- 当

- 链表插入时的并发问题

- 多个线程同时插入元素时,可能会导致链表节点的指针被错误地修改,从而形成环形链表。

一旦链表形成了环形结构,后续的读操作(如 get())会在遍历链表时陷入无限循环。

为了避免 HashMap 的并发死链问题,可以采取以下几种解决方案:

(1) 使用线程安全的集合类

- 使用ConcurrentHashMap替代HashMap

ConcurrentHashMap是专门为多线程环境设计的线程安全集合类。- 它通过分段锁(Segment Lock)或 CAS 操作来保证线程安全,避免了死链问题。

(2) 手动加锁

- 如果必须使用

HashMap,可以通过synchronized或显式锁(如ReentrantLock)来保护对其的修改操作。

(3) 使用 Collections.synchronizedMap() 包装

- 将

HashMap包装成线程安全的集合。

项目管理

Maven✨

Maven Getting Started Guide – Maven

黑马程序员Maven全套教程,maven项目管理从基础到高级,Java项目开发必会管理工具maven_哔哩哔哩_bilibili

项目中源码目录,资源文件夹目录等都是maven设置的

Maven 提倡使用一个共同的标准目录结构,Maven 使用约定优于配置的原则,大家尽可能的遵守这样的目录结构。如下所示:

| 目录 | 目的 |

|---|---|

| ${basedir} | 存放pom.xml和所有的子目录 |

| ${basedir}/src/main/java | 项目的java源代码 |

| ${basedir}/src/main/resources | 项目的资源,比如说property文件,springmvc.xml |

| ${basedir}/src/test/java | 项目的测试类,比如说Junit代码 |

| ${basedir}/src/test/resources | 测试用的资源 |

| ${basedir}/src/main/webapp/WEB-INF | web应用文件目录,web项目的信息,比如存放web.xml、本地图片、jsp视图页面 |

| ${basedir}/target | 打包输出目录 |

| ${basedir}/target/classes | 编译输出目录 |

| ${basedir}/target/test-classes | 测试编译输出目录 |

| Test.java | Maven只会自动运行符合该命名规则的测试类 |

| ~/.m2/repository | Maven默认的本地仓库目录位置 |

POM( Project Object Model,项目对象模型 ) 是 Maven 工程的基本工作单元,是一个XML文件,包含了项目的基本信息,用于描述项目如何构建,声明项目依赖,等等。

执行任务或目标时,Maven 会在当前目录中查找 POM。它读取 POM,获取所需的配置信息,然后执行目标。

POM 中可以指定以下配置:

- 项目依赖

- 插件

- 执行目标

- 项目构建 profile

- 项目版本

- 项目开发者列表

- 相关邮件列表信息

1 | <project xmlns = "http://maven.apache.org/POM/4.0.0" |

所有 POM 文件都需要 project 元素和三个必需字段:groupId,artifactId,version。

| 节点 | 描述 |

|---|---|

| project | 工程的根标签。 |

| modelVersion | 模型版本需要设置为 4.0。 |

| groupId | 这是工程组的标识。它在一个组织或者项目中通常是唯一的。例如,一个银行组织 com.companyname.project-group 拥有所有的和银行相关的项目。 |

| artifactId | 这是工程的标识。它通常是工程的名称。例如,消费者银行。groupId 和 artifactId 一起定义了 artifact 在仓库中的位置。 |

| version | 这是工程的版本号。在 artifact 的仓库中,它用来区分不同的版本。例如:com.company.bank:consumer-banking:1.0 com.company.bank:consumer-banking:1.1 |

依赖管理

1 | <dependencies> |

插件管理

1 | <build> |

其他常用元素

properties: 定义项目中的一些属性变量:1

2

3

4<properties>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

</properties>

repositories: 定义项目的依赖库:1

2

3

4

5

6<repositories>

<repository>

<id>central</id>

<url>https://repo.maven.apache.org/maven2</url>

</repository>

</repositories>

dependencyManagement: 用于管理依赖的版本,特别是在多模块项目中:1

2

3

4

5

6

7

8

9<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-core</artifactId>

<version>5.3.9</version>

</dependency>

</dependencies>

</dependencyManagement>

profiles: 用于定义不同的构建配置,可以根据不同的环境进行构建:1

2

3

4

5

6

7

8

9

10

11

12

13

14<profiles>

<profile>

<id>development</id>

<properties>

<environment>dev</environment>

</properties>

</profile>

<profile>

<id>production</id>

<properties>

<environment>prod</environment>

</properties>

</profile>

</profiles>

继承: 通过parent元素,一个POM文件可以继承另一个POM文件的配置:1

2

3

4

5<parent>

<groupId>com.example</groupId>

<artifactId>parent-project</artifactId>

<version>1.0-SNAPSHOT</version>

</parent>

聚合: 通过modules元素,一个POM文件可以管理多个子模块:1

2

3

4<modules>

<module>module1</module>

<module>module2</module>

</modules>

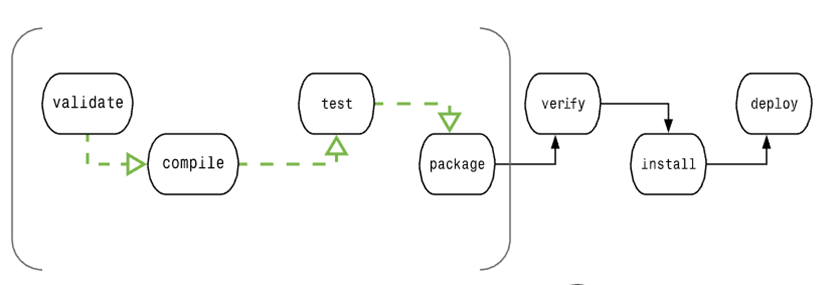

生命周期

个典型的 Maven 构建(build)生命周期是由以下几个阶段的序列组成的:

| 阶段 | 处理 | 描述 |

|---|---|---|

| 验证 validate | 验证项目 | 验证项目是否正确且所有必须信息是可用的 |

| 编译 compile | 执行编译 | 源代码编译在此阶段完成 |

| 测试 Test | 测试 | 使用适当的单元测试框架(例如JUnit)运行测试。 |

| 包装 package | 打包 | 将编译后的代码打包成可分发的格式,例如 JAR 或 WAR |

| 检查 verify | 检查 | 对集成测试的结果进行检查,以保证质量达标 |

| 安装 install | 安装 | 安装打包的项目到本地仓库,以供其他项目使用 |

| 部署 deploy | 部署 | 拷贝最终的工程包到远程仓库中,以共享给其他开发人员和工程 |

为了完成 default 生命周期,这些阶段(包括其他未在上面罗列的生命周期阶段)将被按顺序地执行。

Maven 有以下三个标准的生命周期:

1、Clean 生命周期:

- clean:删除目标目录中的编译输出文件。这通常是在构建之前执行的,以确保项目从一个干净的状态开始。

2、Default 生命周期(也称为 Build 生命周期):

- validate:验证项目的正确性,例如检查项目的版本是否正确。

- compile:编译项目的源代码。

- test:运行项目的单元测试。

- package:将编译后的代码打包成可分发的格式,例如 JAR 或 WAR。

- verify:对项目进行额外的检查以确保质量。

- install:将项目的构建结果安装到本地 Maven 仓库中,以供其他项目使用。

- deploy:将项目的构建结果复制到远程仓库,以供其他开发人员或团队使用。

3、Site 生命周期:

- site:生成项目文档和站点信息。

- deploy-site:将生成的站点信息发布到远程服务器,以便共享项目文档。

仓库

在 Maven 的术语中,仓库是一个位置(place)。

Maven 仓库是项目中依赖的第三方库,这个库所在的位置叫做仓库。

在 Maven 中,任何一个依赖、插件或者项目构建的输出,都可以称之为构件。

Maven 仓库能帮助我们管理构件(主要是JAR),它就是放置所有JAR文件(WAR,ZIP,POM等等)的地方。

Maven 仓库有三种类型:

- 本地(local)

- 中央(central)

- 远程(remote)

Maven 的本地仓库,在安装 Maven 后并不会创建,它是在第一次执行 maven 命令的时候才被创建。

运行 Maven 的时候,Maven 所需要的任何构件都是直接从本地仓库获取的。如果本地仓库没有,它会首先尝试从远程仓库下载构件至本地仓库,然后再使用本地仓库的构件。

默认情况下,不管Linux还是 Windows,每个用户在自己的用户目录下都有一个路径名为 .m2/repository/ 的仓库目录。

Maven 本地仓库默认被创建在 %USER_HOME% 目录下。要修改默认位置,在 %M2_HOME%\conf 目录中的 Maven 的 settings.xml 文件中定义另一个路径。1

<settings xmlns="http://maven.apache.org/SETTINGS/1.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/SETTINGS/1.0.0 http://maven.apache.org/xsd/settings-1.0.0.xsd"> <localRepository>C:/MyLocalRepository</localRepository> </settings>

当运行 Maven 命令,Maven 将下载依赖的文件到你指定的路径中。

Maven 中央仓库是由 Maven 社区提供的仓库,其中包含了大量常用的库。

中央仓库包含了绝大多数流行的开源Java构件,以及源码、作者信息、SCM、信息、许可证信息等。一般来说,简单的Java项目依赖的构件都可以在这里下载到。

中央仓库的关键概念:

- 这个仓库由 Maven 社区管理。

- 不需要配置。

- 需要通过网络才能访问。

如果 Maven 在中央仓库中也找不到依赖的文件,它会停止构建过程并输出错误信息到控制台。为避免这种情况,Maven 提供了远程仓库的概念,它是开发人员自己定制仓库,包含了所需要的代码库或者其他工程中用到的 jar 文件。

举例说明,使用下面的 pom.xml,Maven 将从远程仓库中下载该 pom.xml 中声明的所依赖的(在中央仓库中获取不到的)文件。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0

http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.companyname.projectgroup</groupId>

<artifactId>project</artifactId>

<version>1.0</version>

<dependencies>

<dependency>

<groupId>com.companyname.common-lib</groupId>

<artifactId>common-lib</artifactId>

<version>1.0.0</version>

</dependency>

<dependencies>

<repositories>

<repository>

<!--自定义远程仓库-->

<id>companyname.lib1</id>

<url>http://download.companyname.org/maven2/lib1</url>

</repository>

<repository>

<id>companyname.lib2</id>

<url>http://download.companyname.org/maven2/lib2</url>

</repository>

</repositories>

</project>

当执行 Maven 构建命令时,Maven 开始按照以下顺序查找依赖的库:

- 步骤 1 - 在本地仓库中搜索,如果找不到,执行步骤 2,如果找到了则执行其他操作。

- 步骤 2 - 在中央仓库中搜索,如果找不到,并且有一个或多个远程仓库已经设置,则执行步骤 4,如果找到了则下载到本地仓库中以备将来引用。

- 步骤 3 - 如果远程仓库没有被设置,Maven 将简单的停滞处理并抛出错误(无法找到依赖的文件)。

- 步骤 4 - 在一个或多个远程仓库中搜索依赖的文件,如果找到则下载到本地仓库以备将来引用,否则 Maven 将停止处理并抛出错误(无法找到依赖的文件)。

Maven 仓库默认在国外, 国内使用难免很慢,我们可以更换为阿里云的仓库。

修改 maven 根目录下的 conf 文件夹中的 settings.xml 文件,在 mirrors 节点上,添加内容如下:1

2

3

4

5

6<mirror>

<id>aliyunmaven</id>

<mirrorOf>*</mirrorOf>

<name>阿里云公共仓库</name>

<url>https://maven.aliyun.com/repository/public</url>

</mirror>

如果想使用其它代理仓库,可在 1

2

3

4

5

6

7

8

9

10<repository>

<id>spring</id>

<url>https://maven.aliyun.com/repository/spring</url>

<releases>

<enabled>true</enabled>

</releases>

<snapshots>

<enabled>true</enabled>

</snapshots>

</repository>

在你的 pom.xml 文件 1

2

3

4

5<dependency>

<groupId>[GROUP_ID]</groupId>

<artifactId>[ARTIFACT_ID]</artifactId>

<version>[VERSION]</version>

</dependency>

常用命令

mvn clean- 清理项目,删除

target目录(该目录包含了编译和打包过程中生成的所有文件)。

- 清理项目,删除

mvn compile- 编译项目的源代码。默认情况下,会查找

src/main/java目录下的所有.java文件,并将编译后的.class文件输出到target/classes目录中。

- 编译项目的源代码。默认情况下,会查找

mvn test- 使用合适的单元测试框架(如 JUnit 或 TestNG)运行项目的测试代码。默认情况下,测试代码位于

src/test/java目录下。

- 使用合适的单元测试框架(如 JUnit 或 TestNG)运行项目的测试代码。默认情况下,测试代码位于

mvn package- 将编译好的字节码打包成可分发的格式,例如 JAR 或 WAR 文件。这个命令首先执行

compile和test,然后将项目打包并存放在target目录中。

- 将编译好的字节码打包成可分发的格式,例如 JAR 或 WAR 文件。这个命令首先执行

mvn install- 安装打包好的构件到本地仓库(通常是用户主目录下的

.m2/repository),以便它可以被其他项目作为依赖使用。此命令还会执行package的所有步骤。

- 安装打包好的构件到本地仓库(通常是用户主目录下的

mvn deploy- 在集成或发布阶段使用,用于将最终包复制到远程仓库,使得其他开发者或项目可以共享这个构件。

mvn site- 生成关于项目的站点文档,包括测试覆盖率报告、依赖列表等信息。

mvn clean install- 组合命令,先清理项目 (

clean) 然后安装 (install) 到本地仓库。这是非常常见的组合,用于确保在干净环境下重新构建整个项目。

- 组合命令,先清理项目 (

mvn dependency:tree- 显示项目依赖树,有助于分析依赖冲突或了解项目依赖关系。

mvn archetype:generate- 生成一个新的 Maven 项目结构,通过交互式的方式选择项目模板

数据库

MySQL✨

事务

一组操作的集合,不可分割的一个工作单位. 事务会把所有操作作为一个整体向系统提交或撤销操作,即这些操作要么同时成功,要么同时失败.

事务四大特性

- 原子性(Atomicity):事务中的所有操作要么全部完成,要么全部不执行。

- 一致性(Consistency):事务应该将数据库从一种一致状态转换为另一种一致状态。

- 隔离性(Isolation):并发事务之间相互隔离,不会互相干扰。

- 持久性(Durability):一旦事务提交,所做的更改将是永久性的,即使系统发生故障也不会丢失。

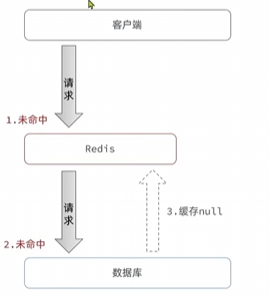

事务并发问题

多个事务并发进行的问题

脏读

一个事务读到另外一个事务还没有提交的数据

不可重复读

一个事务先后读取同一条记录,但两次读取的数据不同,称之为不可重复读

幻读

一个事务按照条件查询数据时,没有对应的数据行,但是在插入数据时,又发现这行数据已经存在

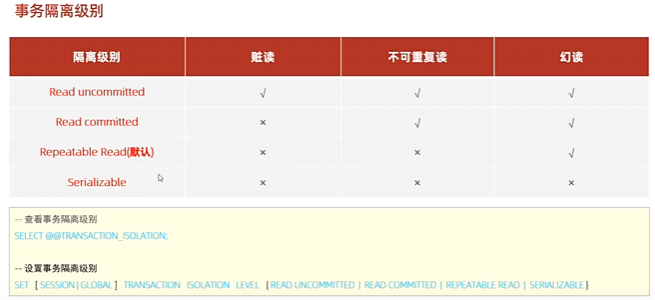

事务隔离级别

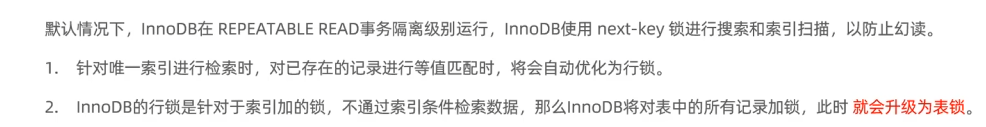

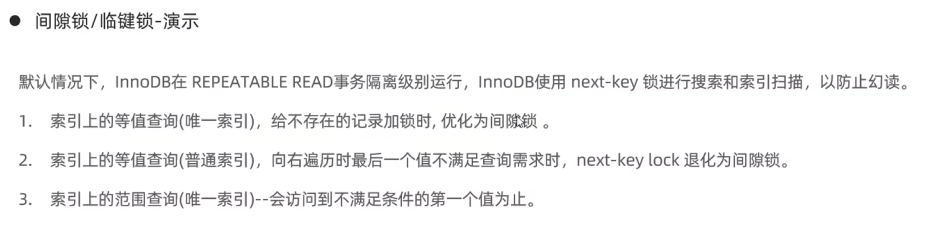

MySQL 支持四种标准的事务隔离级别:

- 读未提交(Read Uncommitted):最低级别的隔离,允许脏读、不可重复读和幻读。

- 读已提交(Read Committed):防止脏读,但允许不可重复读和幻读。

- 可重复读(Repeatable Read):默认级别,防止脏读和不可重复读,但允许幻读。

- 串行化(Serializable):最高级别的隔离,完全防止脏读、不可重复读和幻读,但会降低并发性能。

1 | SET SESSION TRANSACTION ISOLATION LEVEL REPEATABLE READ; |

1. 默认情况下:事务需要显式提交

- 在

START TRANSACTION开始一个事务后,所有对数据库的修改操作(如UPDATE、INSERT等)都只会暂时存在于事务的上下文中,而不会直接写入数据库。 - 这些更改对其他事务是不可见的(根据隔离级别),直到你显式调用

COMMIT提交事务。 - 如果你调用

ROLLBACK,则所有的更改会被撤销,数据库恢复到事务开始前的状态。

2. 如果未提交且会话结束

如果你在事务中执行了更新语句,但没有显式调用COMMITROLLBACK

,然后会话意外终止(例如客户端断开连接),MySQL 的行为如下:

- InnoDB 存储引擎(支持事务):事务会被自动回滚,所有未提交的更改都会被撤销。

- MyISAM 存储引擎(不支持事务):由于 MyISAM 不支持事务,所有操作会立即生效,无法回滚。

3. autocommit 模式的影响

- MySQL 默认开启了 autocommit 模式(

autocommit=1)。在这种模式下,每条单独的 SQL 语句都会被视为一个独立的事务,并在执行后自动提交。 - 当你使用

START TRANSACTION或BEGIN时,会临时禁用 autocommit 模式,直到事务结束(通过COMMIT或ROLLBACK)。 - 如果你没有显式提交事务,而会话结束时 autocommit 模式重新启用,InnoDB 会自动回滚未提交的事务。

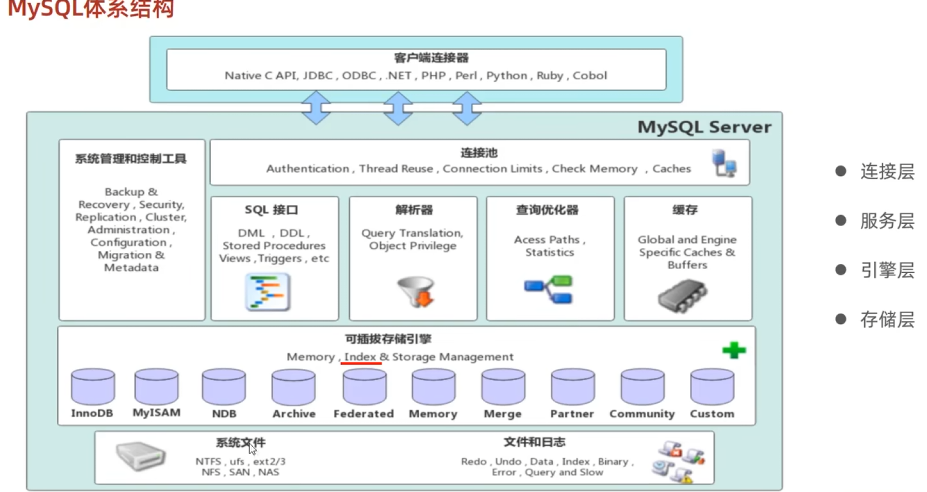

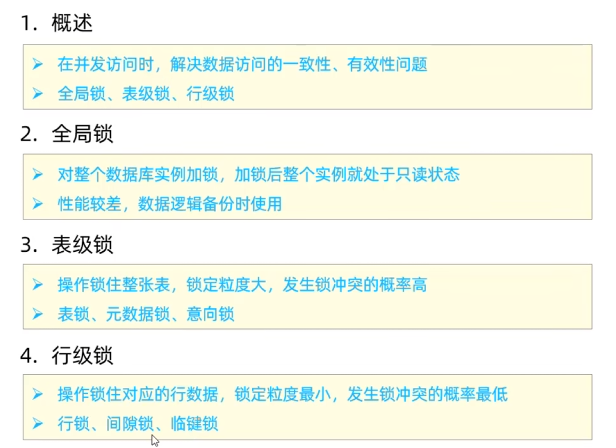

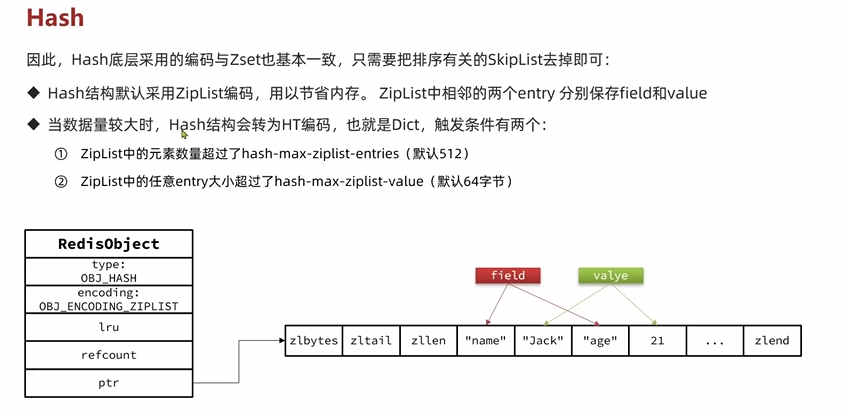

存储引擎

1. InnoDB

默认存储引擎:从 MySQL 5.5 开始成为默认存储引擎。

特性

- 事务支持:完全支持 ACID(原子性、一致性、隔离性、持久性)属性,适合需要高可靠性和数据一致性的应用。

- 行级锁定:提供高效的并发处理能力,减少了锁冲突的可能性。

行级锁定是指在对数据进行操作时,只锁定受影响的具体行而不是整个表。这意味着在同一张表中,不同事务可以同时对不同的行进行读写操作。

- 外键支持:唯一支持外键约束的存储引擎,有助于维护数据完整性和引用完整性。

- 崩溃恢复:通过 redo 和 undo 日志实现快速崩溃恢复。

- 聚簇索引:每个表都使用主键作为聚簇索引,提高了查询效率。

2. MyISAM

- 早期默认存储引擎:在 MySQL 5.5 之前是默认的存储引擎。

- 特性

- 不支持事务:适用于对事务要求不高、以读操作为主的场景。

- 表级锁定:整个表被锁定进行写入操作,可能导致高并发下的性能瓶颈。

- 全文索引:MyISAM 支持全文搜索,这在某些文本检索应用中非常有用。

- 压缩表:可以创建只读压缩表,节省存储空间。

- 简单高效:对于简单的查询操作,MyISAM 提供了较高的性能。

3. Memory (Heap)

- 内存中的表:数据存放在内存中,因此访问速度非常快。

- 特性

- 临时性:重启服务器后数据丢失,适用于缓存数据或临时计算。

- 表级锁定:由于是内存操作,锁定粒度较粗并不会显著影响性能。

- 哈希索引:默认使用哈希索引,对于精确匹配查询特别有效。

- 不支持事务:与 MyISAM 类似,Memory 引擎也不支持事务。

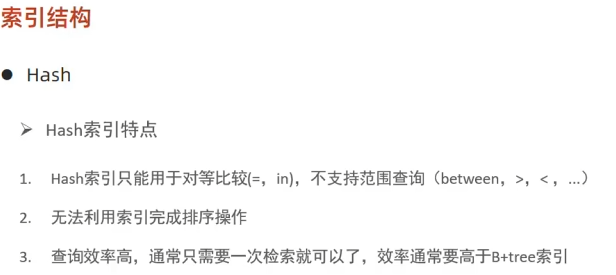

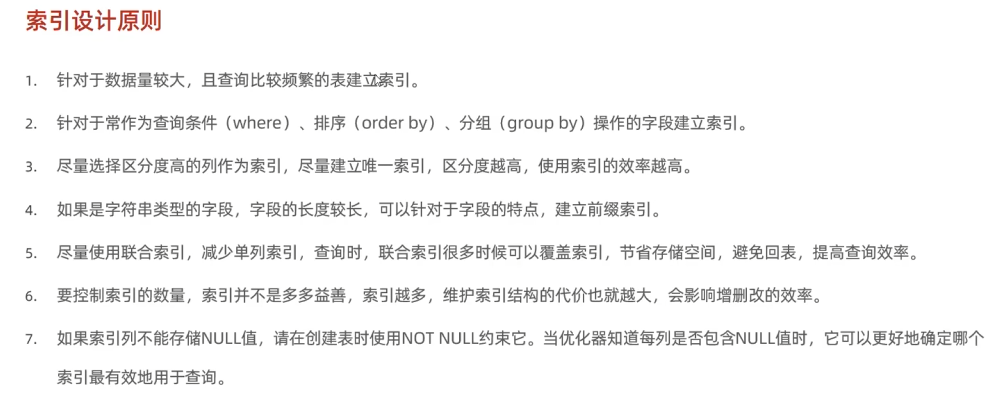

索引

- 定义:索引是一种特殊的数据结构,用于加速数据库表中数据的检索速度。

- 目的:减少查询时需要扫描的数据量,从而提高查询性能。

代价:虽然索引可以加快查询速度,但它们也会占用额外的存储空间,并且在进行插入、更新和删除操作时会增加一些开销。

B-Tree 索引

适用范围:这是 MySQL 中最常用的索引类型,默认情况下,

CREATE INDEX创建的就是 B-Tree 索引。特点

- 支持全键值、键值范围和键前缀查找(如

LIKE 'abc%')。 - 能够有效地支持等值查询和范围查询(例如

>、<、BETWEEN、IN等)。 - 适用于大多数类型的比较操作(包括

=、<>、>、>=、<、<=)。

- 支持全键值、键值范围和键前缀查找(如

(1) 阶数(Order)

- B 树的阶数 t是一个定义其结构的重要参数。每个节点最多可以有 2t−1个键值,并且至少包含 t−1个键值(除了根节点外)。每个内部节点最多有 2t个子节点。

这种设计确保了树的高度保持较低,从而减少了查找所需的时间。(2) 节点类型

内部节点:除了叶子节点之外的所有节点。它们存储键值和指向子节点的指针。

- 叶子节点:位于树的最底层,直接存储数据或指向数据的指针。

2. B+ 树(B+Tree)

定义

- B+ 树是 B 树的一种变体,特别优化了范围查询性能。与 B 树不同的是,B+ 树的所有数据都存储在叶子节点中,而内部节点仅用于导航目的。

特点

- 所有数据都在叶子节点:这意味着所有的实际数据记录都存储在叶子节点上,而不是分散在整棵树中。这样做的好处是可以将更多的键值放入内部节点,从而进一步降低树的高度。

- 叶子节点链表:B+ 树的叶子节点通过双向链表连接在一起,这极大地提高了范围查询的效率,因为一旦定位到起始位置,就可以沿着链表顺序访问后续的数据。

- 更高的分支因子:由于内部节点不存储数据,因此可以容纳更多的子节点指针,这有助于进一步减少树的高度,提高查找效率。

3. B 树 vs. B+ 树

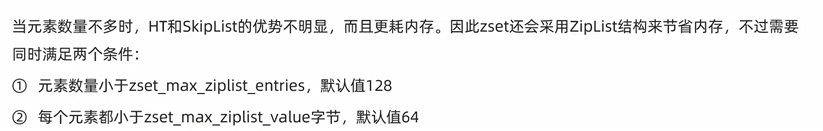

| 特性 | B 树 | B+ 树 |

|---|---|---|

| 数据存储位置 | 内部节点和叶子节点都可以存储数据 | 仅叶子节点存储数据,内部节点仅用于导航 |

| 叶子节点连接 | 不具备叶子节点间的直接连接 | 叶子节点之间通过链表相连,便于范围查询 |

| 树的高度 | 较高,因为内部节点也需要存储数据 | 更低,因为内部节点可以存储更多键值,减少了树的高度 |

| 适用场景 | 适合于大多数基本查询操作 | 特别适合于范围查询和排序操作 |

| 特性 | B树 | B+树 |

|---|---|---|

| 数据存储 | 数据(key-value)存储在所有节点(叶子+内部) | 数据仅存储在叶子节点,内部节点只存 key |

| 指针 | 内部节点的指针指向子节点 | 叶子节点间有额外的顺序指针(双向链表) |

| 搜索 | 可以在非叶子节点找到数据,搜索可能提前结束 | 必须走到叶子节点才能找到数据,查询路径固定 |

| 范围查询 | 范围查询效率较低,需回溯 | 范围查询效率高(叶子节点是链表,顺序扫描快) |

| 磁盘I/O | 较多随机I/O | 较少随机I/O,访问更快 |

| 树的高度 | 相对较高 | 相对较低(因为内部节点更小,能容纳更多 key) |

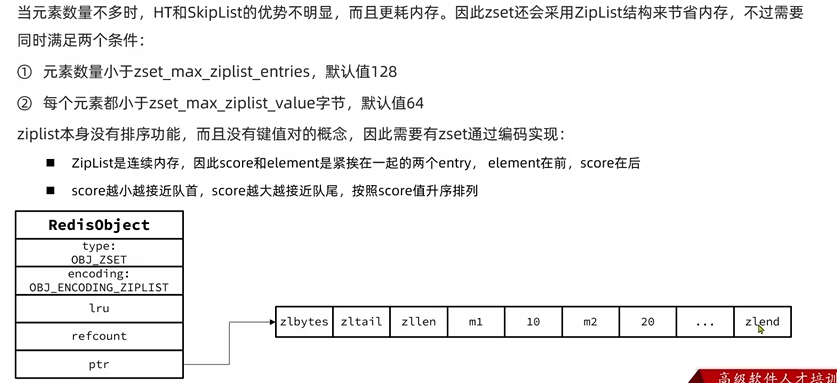

| 特性 | 聚集索引 | 二级索引 |

|---|---|---|

| 物理存储 | 数据按索引键顺序存储 | 数据存储位置与索引无关,索引中包含指向数据行的指针 |

| 数量限制 | 每个表只能有一个 | 可以有多个 |

| 查询效率 | 对于按索引键排序的查询非常高效 | 需要两次查找(先找索引,再找数据行),但适用于多种查询条件 |

| 更新开销 | 更新可能导致大量数据重排,开销较大 | 更新仅需修改索引结构,开销相对较小 |

SQL优化

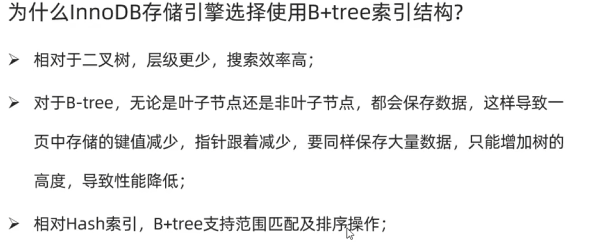

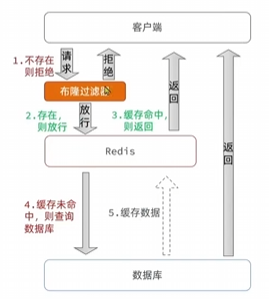

1. 使用 EXPLAIN 分析查询性能

🔹 EXPLAIN 可以 分析 SQL 查询的执行计划,查看 索引使用情况、扫描方式 和 查询优化器的决策。1

EXPLAIN SELECT * FROM users WHERE name = 'Alice';

🚀 关键字段解读:

| 字段 | 作用 | 优化建议 |

|---|---|---|

id | 查询的执行顺序 | ID 越大,优先执行 |

select_type | 查询类型 | SIMPLE 是最优 |

table | 查询的表 | 确保表索引优化 |

type | 访问类型 | ALL(全表扫描) 最差,index、ref、range、const 最优 |

possible_keys | 可能使用的索引 | 如果 NULL,说明没有合适的索引 |

key | 实际使用的索引 | 确保索引合理 |

rows | 需要扫描的行数 | 越少越好 |

Extra | 额外信息 | 避免 Using filesort 和 Using temporary |

🔹 优化示例1

EXPLAIN SELECT * FROM users WHERE email = 'test@example.com';

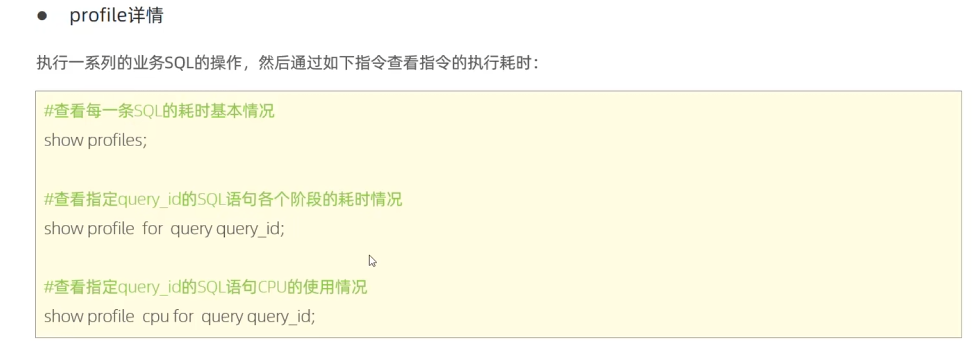

2. 使用 SHOW PROFILE 进行 SQL 运行时间分析

🔹 SHOW PROFILE 详细分析 SQL 在各个阶段的执行时间,如 解析、优化、执行、发送数据。1

2

3sqlCopyEditSET profiling = 1;

SELECT * FROM users WHERE email = 'test@example.com';

SHOW PROFILES;

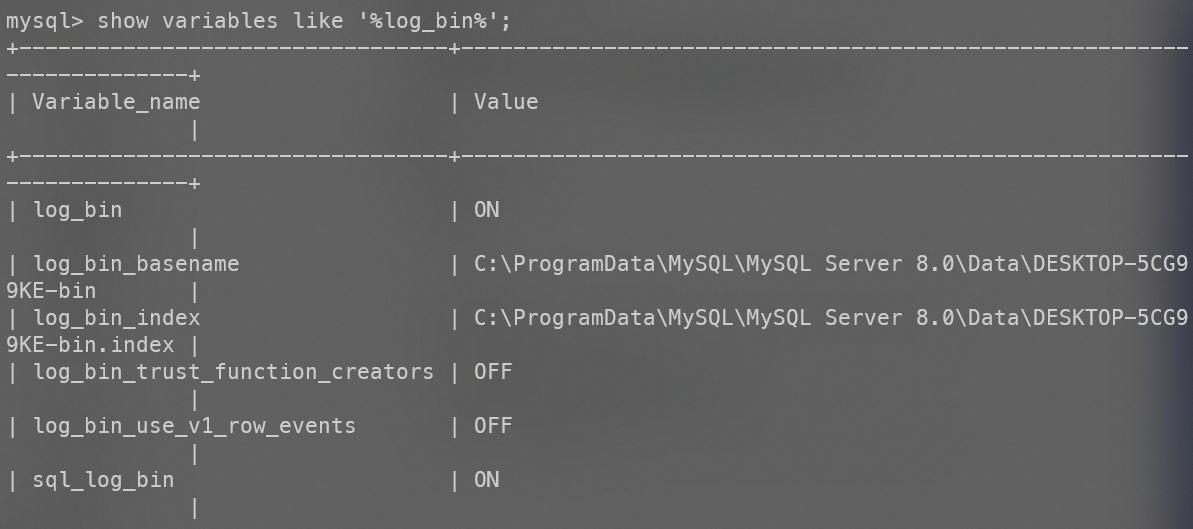

🔹 查看 SQL 具体耗时1